苏州大学LCM实验室与中国移动(苏州)联合完成的一项突破性研究,为人工智能领域带来了全新视角。该研究聚焦于AI系统的记忆管理能力评估,相关成果已通过论文编号arXiv:2601.11969v1公开,为行业提供了重要参考。

在人工智能应用中,处理超长文本或对话始终是技术难点。以观看三小时电影为例,人类大脑需要持续记忆情节线索、人物关系等信息以理解结局,而AI系统同样面临如何有效管理和利用历史信息的挑战。传统评估往往关注AI能记住什么,而苏州大学团队首次将焦点转向"AI评判官能否准确评价记忆管理过程",并构建了全球首个专项测试平台MemoryRewardBench。

该平台创新性地设计了涵盖10种记忆管理模式的测试体系,支持从8K到128K词汇量的超长文本处理,包含长篇推理、多轮对话和长文生成三大核心任务。研究团队通过实验发现,AI记忆管理可归纳为三种模式:顺序阅读模式如同逐页读书,逻辑清晰但速度较慢;并行阅读模式类似同时处理多个章节,效率更高但整合复杂;混合阅读模式则结合两者优势,形成最灵活的处理方式。不同任务场景下,这些模式表现出显著差异——推理任务适合顺序模式,信息检索任务则更依赖并行处理。

在评估体系构建方面,研究团队突破传统结果导向的评估方式,引入过程导向的双重评估标准。以长文本推理任务为例,AI不仅需要得出正确结论,还需展示合理的推理链条;多轮对话任务则要求准确追踪对话状态变化;长文生成任务需保持内容连贯性并满足所有约束条件。这种评估方式如同同时检查考试分数和解题步骤,确保评估全面性。

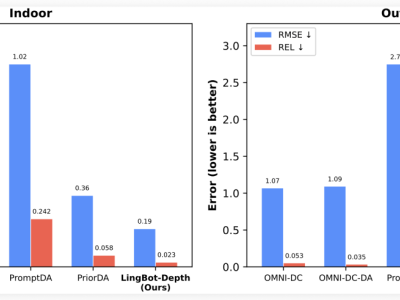

实验结果颠覆了行业传统认知。在对13个先进AI系统的测试中,开源模型与商业模型的性能差距显著缩小。GLM4.5等开源模型在部分任务中得分达68.21分,接近商业模型70分的水平。更引人注目的是,参数规模并非决定性因素——40亿参数的Qwen3-4B模型在特定任务中超越了70亿参数的Qwen2.5-7B模型,证明训练方法和数据质量比模型大小更重要。

研究深入揭示了不同记忆管理模式的特性。顺序处理模式因逻辑链条清晰,评估准确率最高;并行处理模式则因过程复杂,导致所有奖励模型的评估准确率下降。实验还发现奖励模型存在位置偏见——交换两个记忆管理方案的输入顺序可能改变评估结果,类似人类评委受出场顺序影响的现象。约束条件密度对评估效果具有显著影响,约25%的约束密度时评估最准确。

面对超长文本挑战,研究团队观察到奖励模型性能随文本长度增加而下降的规律。128K词汇量的文本处理中,部分700亿参数的大模型性能急剧下滑,甚至不如优化过的中小模型。这表明针对性优化比单纯扩大模型规模更有效。在记忆增强策略方面,为记忆信息添加语义标签可显著提升评估准确性——在多轮对话任务中,带标签的记忆系统使评估准确率提高10-15个百分点。

这项研究为企业级应用开辟了新路径。在法律文件分析、医疗记录整理等长文档处理场景中,企业可借助评估标准选择更可靠的AI系统;AI助手开发可通过优化长期对话能力,解决"忘记"之前内容的问题;教育技术领域则能开发出更智能的学习辅助系统,根据学生学习历史调整教学策略。研究团队同时指出,当前方法在评估复杂并行处理时仍存在局限,未来需开发专用评估模型,并扩展至图像理解、多模态交互等领域。

【常见问题解答】问:MemoryRewardBench平台的核心功能是什么?答:该平台是专门测试AI奖励模型记忆评估能力的基准系统,通过模拟不同记忆管理模式和任务场景,检验AI评判官能否准确判断其他系统的记忆管理质量,测试范围覆盖8K至128K词汇量的文本处理。问:开源AI模型性能提升的关键因素是什么?答:新一代开源模型采用更先进的训练技术和更高质量的数据集,这种"训练质量优先"的策略使部分小参数模型超越了传统大参数模型,证明模型效能取决于训练方法而非单纯规模。问:这项研究对日常AI应用有何具体影响?答:研究将推动AI助手记忆能力升级,例如客服系统能完整追踪对话历史,教育软件可精准记录学习进度,智能助手能更好理解用户长期需求,使AI交互更接近人类对话体验。