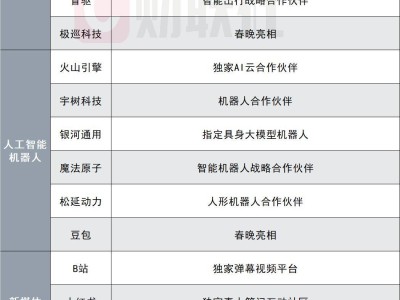

除夕佳节之际,科技领域迎来一则重磅消息:阿里在chat.qwen.ai页面悄然上线了Qwen3.5-Plus与Qwen3.5-397B-A17B两款全新大语言模型,为新春增添了一抹科技亮色。

据官方介绍,Qwen3.5 Plus作为Qwen 3.5系列的最新力作,被定位为新一代大语言模型;而Qwen3.5-397B-A17B则担当起Qwen3.5开源系列的旗舰角色。这两款模型均具备强大的文本处理与多模态任务处理能力,展现出阿里在人工智能领域的深厚积累。

在模型架构上,Qwen3.5实现了全面革新。Qwen3.5-Plus版本总参数规模高达3970亿,但激活参数仅为170亿。这一设计使其性能超越了拥有万亿参数的Qwen3-Max模型,同时部署显存占用大幅降低60%,推理效率显著提升,最大推理吞吐量可提升至原来的19倍,为实际应用提供了更高效的解决方案。

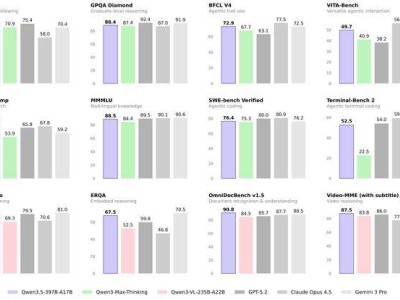

在各项评测中,Qwen3.5系列模型表现卓越。在MMLU-Pro认知能力评测中,Qwen3.5斩获87.8分,超越了GPT-5.2;在博士级难题GPQA测评中,以88.4分的成绩高于Claude 4.5;在指令遵循IFBench评测中,更是以76.5分的成绩刷新了所有模型的纪录。在通用Agent评测BFCL-V4、搜索Agent评测Browsecomp等基准测试中,Qwen3.5的表现均优于Gemini 3 Pro,彰显出其强大的综合实力。

Qwen3.5-397B-A17B同样不负众望,在推理、编程、智能体能力以及多模态理解等多个维度的全方位基准评估中均取得优异成绩。该模型采用创新的混合架构,将线性注意力(Gated Delta Networks)与稀疏混合专家(MoE)技术相结合,在保持强大能力的同时,实现了出色的推理效率。其总参数量达3970亿,但每次前向传播仅激活170亿参数,有效优化了速度与成本。该模型对语言与方言的支持从119种扩展至201种,为全球用户提供了更广泛、更完善的语言服务。

在预训练方面,Qwen3.5从能力、效率与通用性三个维度进行了深入推进。在能力维度,模型在更大规模的视觉-文本语料上进行训练,并加强了中英文、多语言、STEM与推理数据的训练,采用更严格的过滤标准,实现了跨代持平的优异表现,Qwen3.5-397B-A17B与参数量超过1T的Qwen3-Max-Base表现相当。在效率维度,基于Qwen3-Next架构,通过更高稀疏度的MoE、Gated DeltaNet + Gated Attention混合注意力、稳定性优化与多token预测等技术,在32k/256k上下文长度下,Qwen3.5-397B-A17B的解码吞吐量分别是Qwen3-Max的8.6倍和19.0倍,且性能相当;同时,其解码吞吐量也分别是Qwen3-235B-A22B的3.5倍和7.2倍。在通用性维度,通过早期文本-视觉融合与扩展的视觉/STEM/视频数据,实现了原生多模态,在相近规模下优于Qwen3-VL;多语言覆盖从119种增至201种语言/方言,25万词表(相比之前的15万)在多数语言上带来了约10–60%的编码/解码效率提升。

凭借高效的混合架构与原生多模态推理能力,Qwen3.5为通用数字智能体的发展奠定了坚实基础。据悉,下一阶段的研究重点将从模型规模转向系统整合,致力于构建具备跨会话持久记忆的智能体、面向真实世界交互的具身接口以及自我改进机制,目标是打造能够长期自主运行、逻辑一致的系统,将当前以任务为边界的助手升级为可持续、可信任的伙伴。