除夕夜,阿里巴巴宣布正式开源新一代千问大模型千问3.5(Qwen3.5-Plus),这是继Qwen2.5-Max发布后,该公司在人工智能领域的又一重要突破。目前,千问APP与PC端(qianwen.com)已同步上线,用户可通过页面顶部选择新一代模型,体验其强大能力。

与前代模型不同,千问3.5实现了从纯文本模型到原生多模态模型的底层架构重构。在预训练阶段,该模型基于视觉和文本混合token进行训练,视觉理解能力不再作为外挂模块存在,而是与语言能力在底层共同建模。模型大幅增加了中英文、201种语言与方言、STEM学科及推理等数据,突破了以往的数据局限性,使模型能够处理更密集的世界知识和推理逻辑。

千问3.5在参数效率方面表现尤为突出。通过架构优化,该模型以少于40%的参数量实现了超万亿参数的Qwen3-Max基座模型的高性能。这一成果得益于千问团队自研的门控注意力技术,该技术曾获2025年NeurIPS全球AI顶会最佳论文,并被应用于千问3.5的混合架构中。结合线性注意力机制和稀疏混合专家(MoE)模型架构,千问3.5实现了“高参数、低激活”的结构,总参数规模达397B,但每次推理仅激活17B参数,显著提升了推理效率。

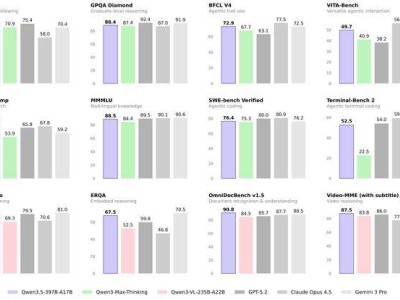

在性能评估方面,千问3.5在多项基准测试中表现优异。在指令遵循IFBench测试中,该模型以76.5分刷新纪录;在MMLU-Pro知识推理评测中,得分87.8,超越GPT-5.2;在博士级难题GPQA测评中,得分88.4,高于Claude 4.5,但与GPT-5.2和Gemini 3 Pro仍有差距。在通用Agent评测BFCL-V4和搜索Agent评测Browsecomp中,千问3.5的性能优于Gemini 3 Pro和GPT-5.2。

原生多模态训练为千问3.5的视觉能力带来显著提升。在多模态推理(MathVison)、通用视觉问答VQA(RealWorldQA)、文本识别和文件理解(CC_OCR)、空间智能(RefCOCO-avg)、视频理解(MLVU)等权威测评中,千问3.5均达到最佳性能。这表明,该模型已不再局限于“语言强、视觉补”的模式,而是形成了统一架构下的完整能力矩阵。

在推理效率方面,千问3.5通过训练稳定优化和多token预测等技术,实现了性能比肩Qwen3-Max的同时,进一步提升了推理效率。在32K上下文场景中,推理吞吐量提升8.6倍;在256K超长上下文中,推理吞吐量最大提升19倍。这一提升使得长文本分析、复杂推理和Agent调度等场景的成本和延迟大幅降低。

基于优异的视觉能力,千问3.5在Agent应用领域取得突破性进展。该模型能够自主操作手机和电脑,高效完成日常任务,支持更多主流APP和指令。在PC端,千问3.5可处理更复杂的多步骤操作,包括跨应用数据整理和自动化流程执行。千问团队构建了可扩展的Agent异步强化学习框架,使端到端加速提升3至5倍,并将插件式智能体支持扩展至百万级规模,标志着千问从对话模型向行动模型的过渡。

据千问团队透露,下一阶段的研究重点将从模型规模转向系统整合,包括构建具备跨会话持久记忆的智能体、开发面向真实世界交互的具身接口,以及探索自我改进机制。这一转变反映了全球大模型竞争的新趋势——从单纯追求“更大、更准”转向“更高效、更可执行”。千问3.5的发布,标志着这场关于模型效率的革命已经拉开帷幕。