在AI界引起广泛关注的消息传来,OpenAI在沉寂六年后,终于再次向公众敞开了其语言模型的大门。8月6日,两款全新的开源模型——gpt-oss-120b和gpt-oss-20b正式亮相,它们均采用了先进的MoE架构,与DeepSeek的多款模型在设计思路上不谋而合。

这两款模型的最大亮点,在于其部署的高效性。据OpenAI介绍,gpt-oss-120b能够在仅需80GB内存的GPU上流畅运行,而gpt-oss-20b的门槛更低,只需16GB内存,就能在边缘设备上发挥作用,为端侧AI提供了本地化的模型选项。它们都采用了MXFP4原生量化技术,其中gpt-oss-120b在H100 GPU上历经210万卡时的训练,而20b版本的训练量仅为前者的十分之一。

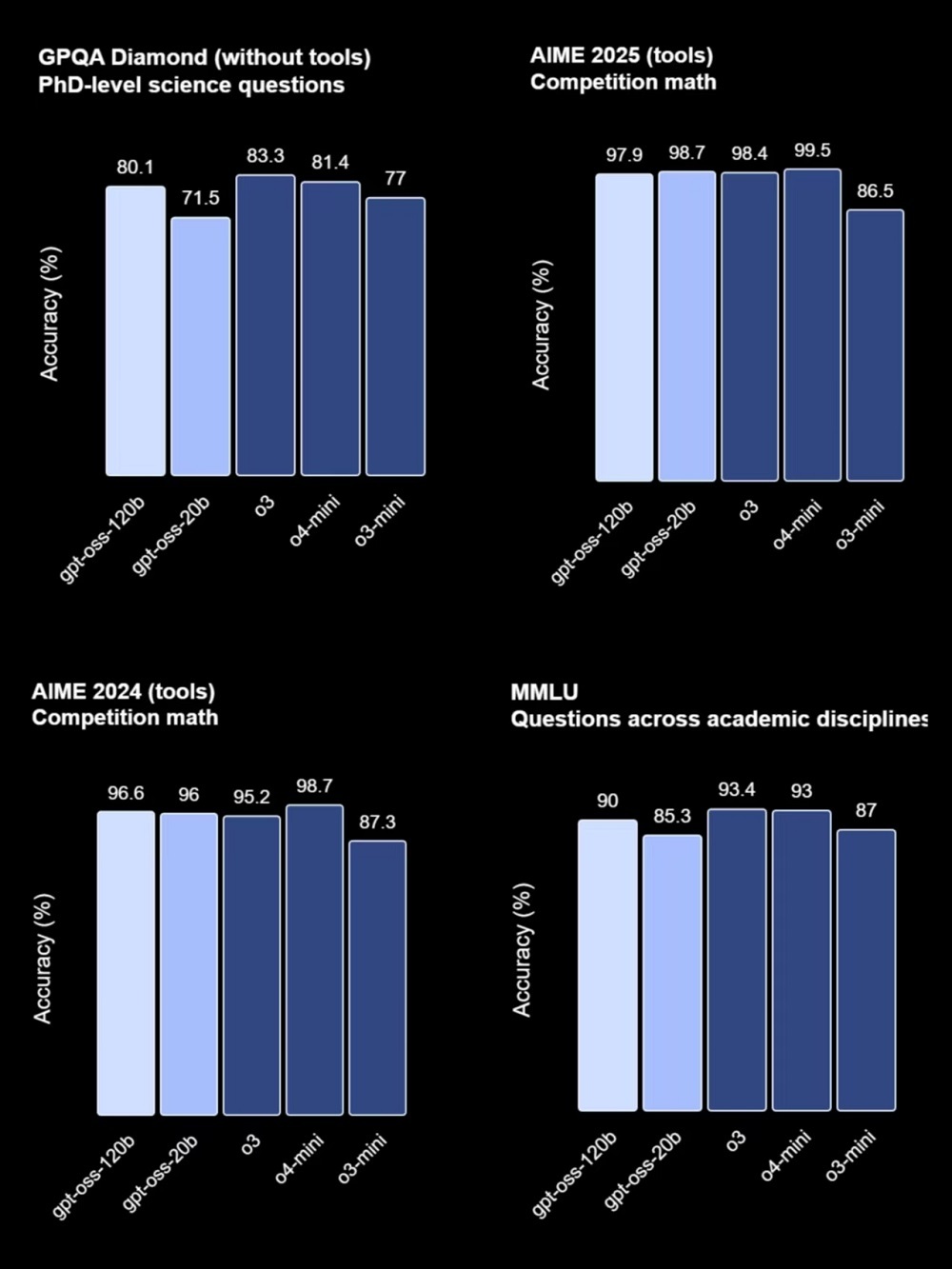

在性能表现上,gpt-oss-120b与OpenAI的o4-mini不相上下,而gpt-oss-20b则与o3-mini相似。它们不仅在工具使用、小样本函数调用等方面表现出色,还展现出了强大的指令遵循能力和网页搜索、Python代码执行等工具使用能力。同时,这两款模型还支持调整推理长度,进一步提升了其实用性。

面向Agent场景,gpt-oss系列模型已经与OpenAI的Responses API实现了兼容,可以用于Agent工作流。这意味着它们不仅具备出色的文本生成能力,还能在更复杂的交互场景中发挥作用。同时,它们还支持多种部署平台,包括Azure、Hugging Face、vLLM等,以及英伟达、AMD等硬件厂商,进一步拓宽了它们的应用范围。

尽管如此,gpt-oss系列模型的高效性和实用性仍然得到了不少用户的认可。有网友表示,他们在体验过程中感受到了这两款模型的快速响应和强大功能。例如,在编程场景中,gpt-oss-120b能够迅速给出项目结构和关键技术点预览;在开发2048小游戏时,也展现出了流畅的运行效果和简洁的UI设计。还有网友尝试用gpt-oss-120b进行SVG图绘制,虽然结果略显简陋,但也足以证明其具备一定的图像生成能力。

值得注意的是,gpt-oss系列模型还得到了多家芯片厂商的支持。英伟达、AMD、Cerebras等企业纷纷宣布了对这两款模型的支持,并展示了它们在自家芯片上的推理速度。其中,Cerebras更是宣称gpt-oss-120b在其芯片上的推理速度达到了每秒超过3000个tokens,创下了OpenAI模型的最快纪录。

目前,gpt-oss-120b和gpt-oss-20b已经上线开源托管平台Hugging Face,普通用户也可以在OpenAI打造的体验网站中直接免费使用。这一举措无疑将进一步推动AI技术的普及和应用,同时也为开源社区带来了新的活力和机遇。然而,对于开源社区而言,能否从OpenAI此次开源中获得实质性的收益和启示,仍需时间和实践的检验。