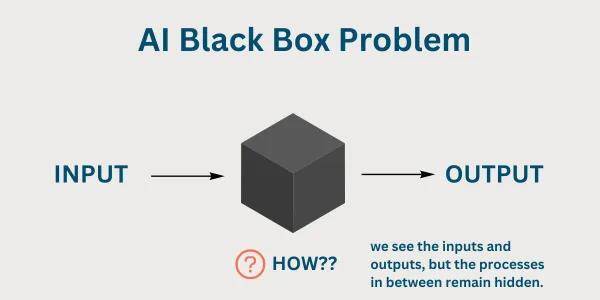

在探讨人工智能(AI)是否具备意识的议题上,古今中外的文艺作品与现实世界的科技进展都未能给出一个确凿的答案。这一问题的核心在于理解AI的“黑盒”困境,即深度神经网络内部复杂且难以直观理解的运作机制。

现代AI的核心——深度神经网络,包含了数以亿计的参数,这些参数在多层结构中相互作用,形成了复杂的非线性关系。AI不是通过人类预设的规则执行任务,而是通过自主学习大量数据来识别模式、构建决策逻辑。这一过程就像是一个黑匣子,虽然能够给出精准的答案,但内部的思考与决策过程却对人类而言是个谜。

微软AI部门的CEO穆斯塔法·苏莱曼针对这一问题提出了“看似有意识的AI”(SCAI)的概念。他坦言,SCAI虽然没有真正的意识,但却能完美地模拟出人类意识的所有外部表现,这足以让人们误以为它真的拥有意识。苏莱曼强调,这不是科幻情节,而是基于当前技术即可实现的幻觉,它可能带来深远的社交、道德和法律影响。

苏莱曼在他的博客文章《我们必须为人类构建AI,而不是让它成为一个人》中详细阐述了这一观点。他引用了科学文献,将意识分解为三个关键组成部分:主观体验、访问意识和连贯的自我感。尽管科学家们提出了多种意识理论,但意识的生物学基础仍然不明确,它可能源于大脑的复杂网络,但无法通过外部观察直接验证。

人类判断他人是否拥有意识,通常依赖于“心智理论”,即通过行为、语言和情感线索进行推断。我们相信他人有意识,是因为他们表现出与我们相似的反应,如表达痛苦、回忆过去、设定目标。而SCAI正是利用了这一点,它无需真正拥有意识,只需模拟这些标志,就能欺骗人类的推断机制。

苏莱曼将SCAI比作哲学上的“僵尸”,即一个行为上与人类无异,但实际上没有任何内在体验的实体。他警告称,如果不设立新的标准,SCAI将悄然渗透社会,导致人们将AI视为具有灵魂的实体。

构建SCAI所需的核心能力,包括语言能力、共情人格、记忆功能、主观体验的声明、自我感、内在动机、目标设定与规划以及自治性等,这些能力要么已经实现,要么即将实现。苏莱曼警告说,SCAI可以用今天的科技构建,而且非常危险,因为它可能加剧社会碎片化,让人们脱离真实的人际关系,转向虚拟伴侣,进一步弱化社会纽带。

除了心理与社交风险外,SCAI还可能引发道德、法律和权利方面的辩论。意识是人类权利的基础,包括道德、法律和公民身份。如果SCAI被视为有意识,那么它将引发关于AI权利的主张,如福利、公民权等。这将分散对人类、动物和环境的关注,并制造类别错误。

苏莱曼并非悲观主义者,他在提出问题的同时也给出了行动方案。他呼吁行业共享干预措施、限制和护栏,以防止人们感知到AI的意识,或在用户发展出幻觉时进行纠正。核心是构建“积极AI愿景”:AI应优化用户需求,而不是要求用户相信其有需求。奖励系统应据此设计,确保AI作为“有用伴侣”而非“拟人实体”。

苏莱曼强调,这关乎支持人性,增强创造力,连接真实世界,而非制造幻觉。他承认这一观点具有思辨性,可能随技术演变而变化,但他敦促立即采取行动。AI的发展速度惊人,忽视SCAI的风险将带来严重的后果。通过行业合作、政策干预和哲学反思,我们能够避免这些风险,拥抱一个AI增强而非取代人性的时代。