当人们与AI对话时,偶尔会遇到令人哭笑不得的场景:模型一本正经地编造历史事件,或是在简单的数学题上栽跟头。从ChatGPT到DeepSeek V3.1,这些现象始终如影随形。近日,OpenAI的一篇研究论文揭示了一个新视角——AI的“幻觉”问题,或许根源在于人类训练它的方式。

AI的“幻觉”并非偶然,而是其训练机制与评估方式共同作用的结果。从内部机制看,大模型通过海量文本学习预测下一个单词的能力。它们会捕捉语句的结构,却难以分辨内容的真实性。例如,当用户上传一张火锅的照片询问“这是什么动物”时,模型可能根据毛色、体型等特征,结合过往学到的狗类特征,得出“金毛”的结论。但若问及“火锅的生日”,模型因缺乏图像中的时间信息,只能硬着头皮编造答案,这便成了典型的“幻觉”现象。

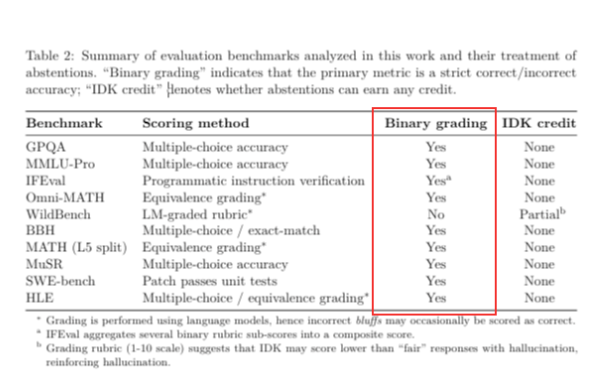

外部的评估方式则进一步放大了这一问题。当前主流的模型测试多采用“对错二分法”:答对加分,答错不扣分。这种机制下,模型若遇到未知问题,选择“不知道”将永远得零分,而随机猜测则有极小概率蒙对。例如,面对“火锅的生日”,模型若瞎猜日期,有1/365的概率得分;若直接放弃,则毫无机会。这种“应试思维”迫使模型优先选择猜测,而非诚实承认能力边界。

OpenAI的研究人员对比了旗下两款模型的表现:老模型o4-mini在测试中正确率虽比GPT-5高2个百分点,但代价是四分之三的问题答错,仅1%的题目会承认“不知道”;而GPT-5则更倾向于直接表示“无法回答”。这种差异反映了模型设计理念的转变——GPT-5虽在排行榜上得分下降,却更接近人类期望的“诚实”行为。

论文指出,AI的“幻觉”无法彻底消除,只能通过调整训练与评估方式来降低其发生频率。例如,当模型遇到无解问题时,应学会跳出“应试”框架,坦诚回应“我不知道”。小模型因知识储备有限,反而更容易承认能力边界;而大模型因“略知一二”,更易自信地给出错误答案,导致幻觉问题更突出。

然而,抑制“幻觉”是否真的符合需求?若两年前的AI对所有不确定问题都回答“不知道”,其用户体验可能大打折扣。事实上,近年研究显示,模型的创造力与“幻觉”存在微妙关联。以GPT-5为例,OpenAI通过调整降低了其幻觉概率,但模型也变得“缺乏人味”——在聊天、文艺创作等场景中表现呆板,引发用户不满。网友甚至发起“拯救GPT-4o”运动,迫使OpenAI重新开放老模型权限。

这一矛盾揭示了AI设计的核心困境:是允许模型犯错以保留创造力,还是要求其绝对可靠而牺牲灵活性?不同用户的需求可能截然相反——有人渴望AI充满灵感,有人则更需要一个可信赖的伙伴。或许,未来的AI将走向分化:针对不同场景,提供“创意型”与“严谨型”两种模式,而非追求单一标准的“完美模型”。