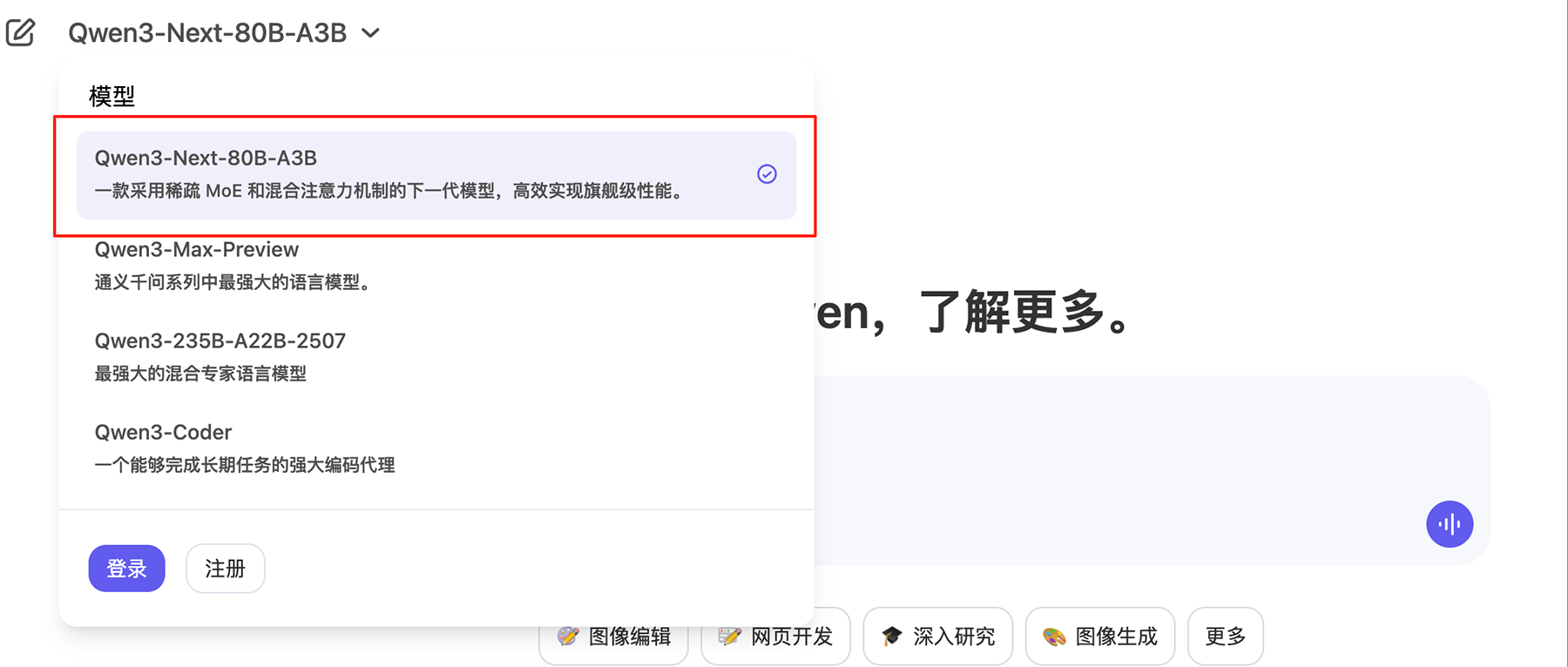

阿里通义实验室近日正式推出新一代基础模型架构Qwen3-Next,并同步开源基于该架构的Qwen3-Next-80B-A3B-Base模型。这款拥有800亿参数的模型仅激活30亿参数,在性能与效率之间实现了突破性平衡,其核心创新在于通过架构优化大幅降低计算资源消耗,同时保持了与更大规模模型相当的推理能力。

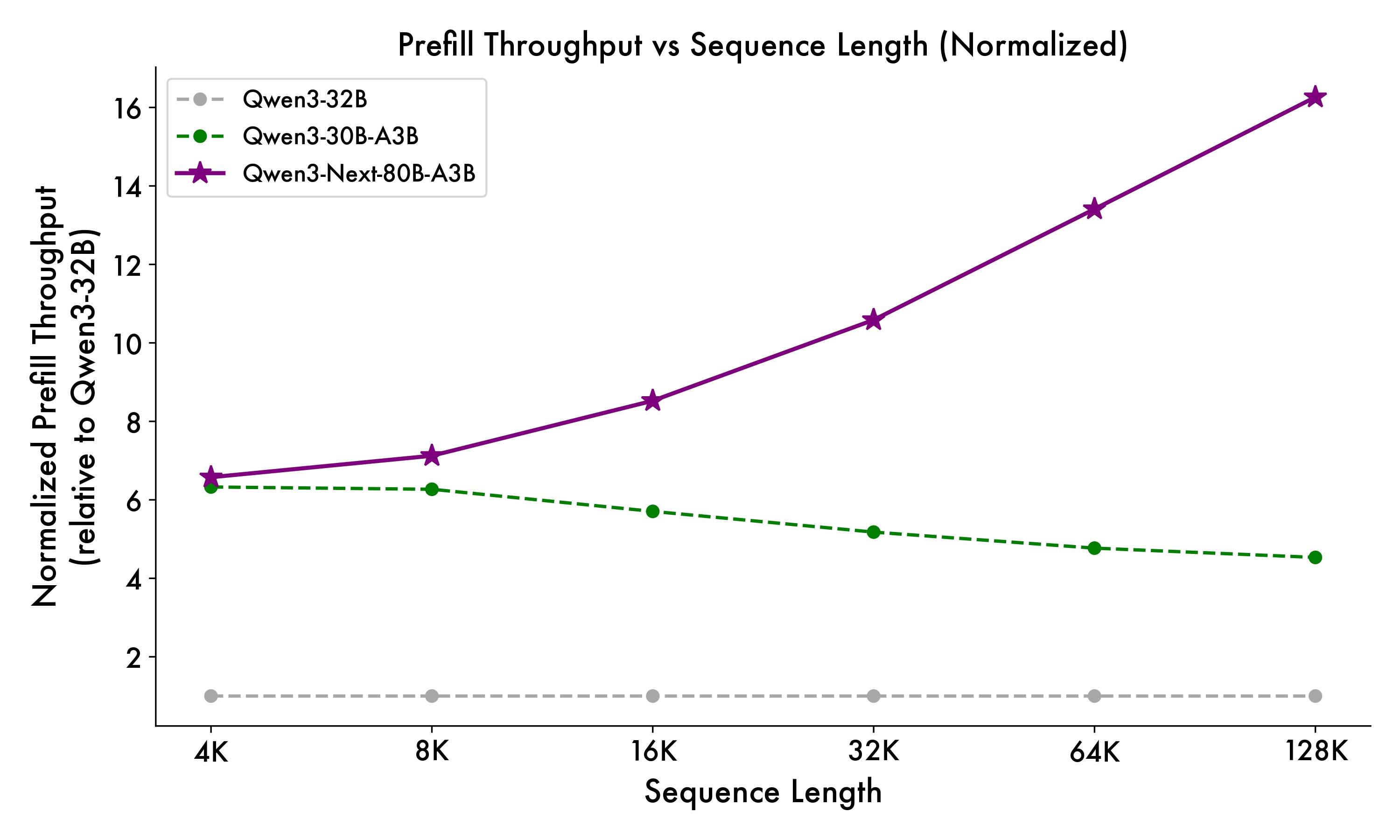

在预训练阶段,Qwen3-Next-80B-A3B-Base模型仅使用Qwen3-32B模型9.3%的GPU计算资源,却在处理超32k上下文时展现出10倍以上的推理吞吐能力。该模型基于15T tokens的Qwen3预训练数据子集训练,通过混合注意力机制、高稀疏度MoE结构等创新技术,实现了计算效率的显著提升。研究团队特别指出,新模型在解码阶段4k上下文场景下吞吐量提升近4倍,长上下文场景中优势更为明显。

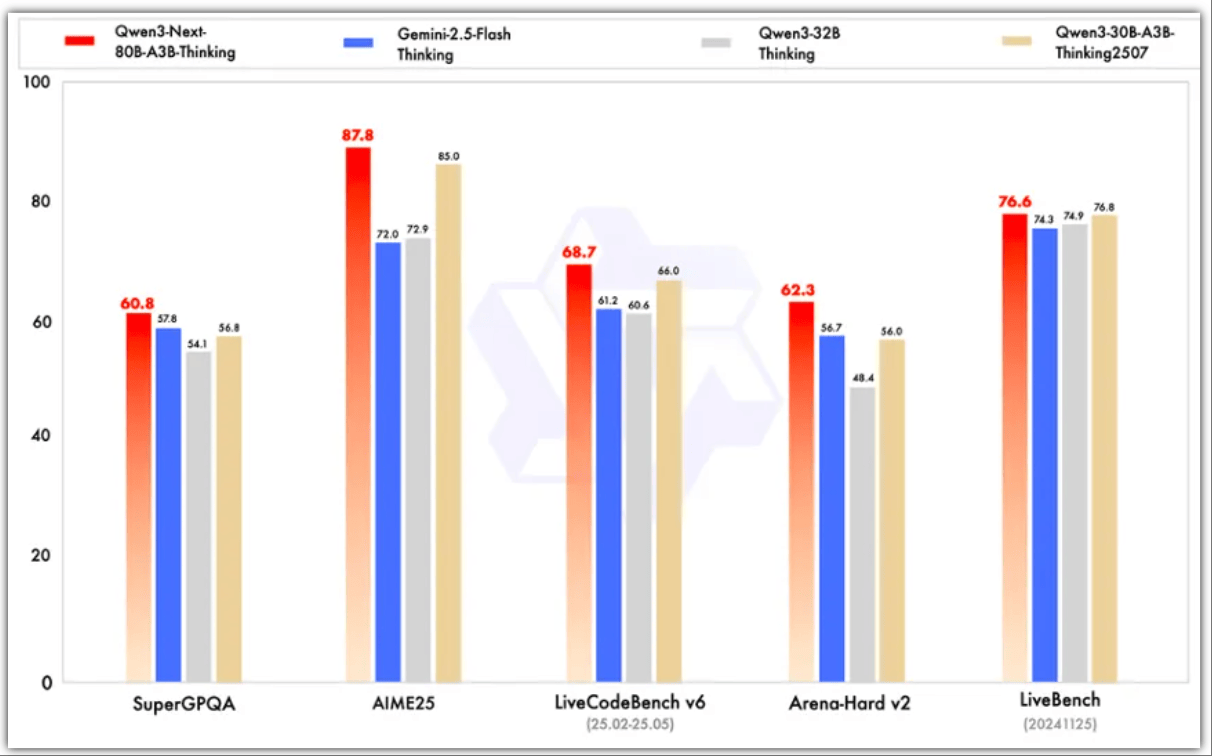

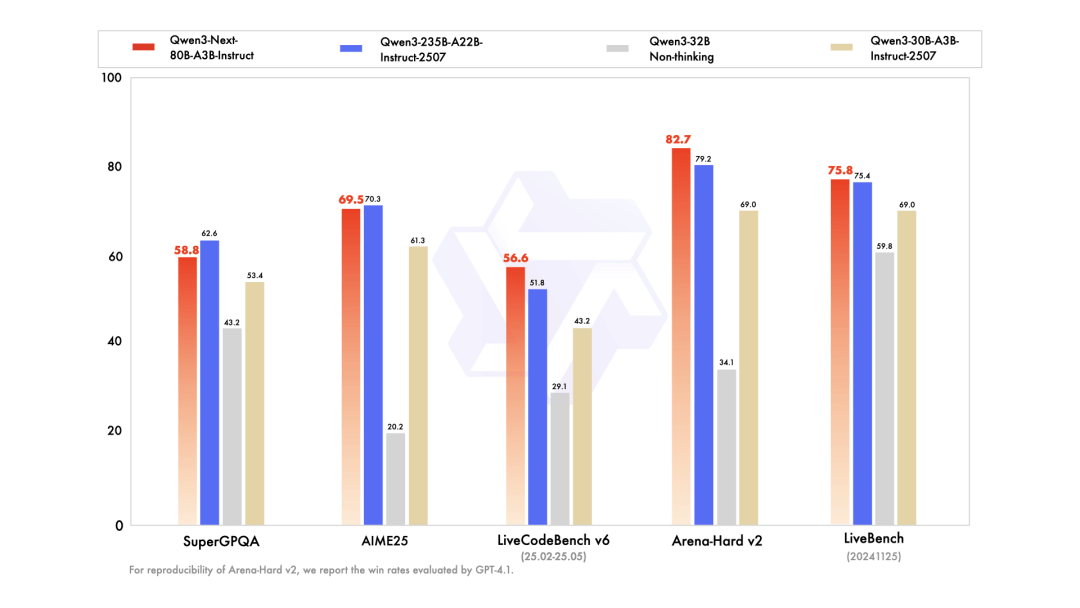

开源版本包含指令模型(Instruct)和思维模型(Thinking)两个变体。前者支持原生262144个token上下文长度,可扩展至百万级token,其性能表现与参数规模更大的Qwen3-235B-A22B-Instruct-2507相当;后者在复杂推理任务中超越谷歌Gemini-2.5-Flash-Thinking,部分指标接近阿里最新旗舰模型。测试数据显示,指令模型在RULER基准测试中256k范围内表现优于层数更多的Qwen3-235B模型,思维模型则在数学推理、编程等任务中展现出显著优势。

架构层面的四大创新构成模型突破的关键:混合注意力机制通过75%层使用Gated DeltaNet与25%层保留标准注意力的组合,实现了超长上下文的有效建模;高稀疏度MoE结构将专家激活比从1:16提升至1:50,大幅降低每个token的计算量;稳定性优化技术包括零中心化、权重衰减layernorm等,确保模型训练的鲁棒性;多Token预测(MTP)机制则通过训练推理一致的多步训练,显著提升了实用场景下的解码效率。这些改进使模型在预填充阶段4k上下文吞吐量接近前代模型的7倍,长上下文场景下提升超过10倍。

开发者社区对多Token预测机制给予高度评价,认为这是模型最突出的创新点。该机制通过同时预测多个未来token,不仅提升了预训练性能,更在实际应用中显著加速了推理过程。实验表明,优化后的MTP在Speculative Decoding场景下接受率大幅提升,为实时交互应用提供了更流畅的体验。

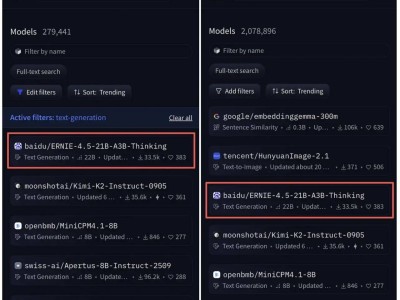

目前,新模型已在魔搭社区和HuggingFace全面开源,开发者可通过Qwen Chat免费体验,或通过阿里云百炼、NVIDIA API Catalog接入服务。研究团队透露,未来将持续优化架构并开发Qwen3.5版本,同时已推出超万亿参数的Qwen3-Max-Preview、文生图模型Qwen-Image-edit、语音识别模型Qwen3-ASR-Flash等垂直领域模型,进一步巩固在开源社区的技术影响力。