中国科学院计算技术研究所的研究团队在NeurIPS 2025会议上发布了一项突破性成果——SpaceServe架构,该架构首次将大语言模型(LLM)推理中的并行-解码(P/D)分离技术扩展至多模态场景,通过创新的“空分复用”机制彻底解决了多模态大语言模型(MLLM)推理中的行头阻塞问题。

随着MLLM在图像理解、视频分析等高分辨率任务中的广泛应用,其推理流程中的多模态编码阶段逐渐成为性能瓶颈。传统系统如vLLM采用“时间复用”策略,即GPU需先完成视觉或音频编码任务后,才能切换至文本解码任务。这种设计在高并发场景下会引发严重问题:一个高分辨率图像的编码可能耗时数百毫秒,导致所有等待生成文本的解码请求被迫阻塞,造成解码器“饥饿”,输出token耗时(TPOT)随请求量激增而急剧上升,系统吞吐量大幅下降。

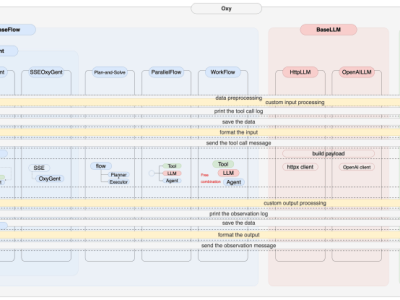

研究团队提出的SpaceServe架构通过“空分复用”技术,将传统的时间串行执行模式转变为空间并行执行模式。定量分析显示,视觉编码器具有计算密集、内存带宽需求低的特点,而文本解码器则内存密集、高度依赖HBM带宽存储KV Cache。二者资源需求互补,却在时间复用架构下被迫串行执行,导致GPU资源浪费。SpaceServe的核心创新在于将编码器与解码器解耦,并利用现代GPU的细粒度流式多处理器(SM)分区能力,实现二者在同一GPU上的并发执行。

该架构包含三大关键技术:首先,通过EPD(Encoder-Prefill-Decode)三阶段逻辑解耦与物理共置,将多模态编码器从共享文本解码器中完全分离,支持独立调度;其次,采用TWSRFT(Time-Window Shortest Remaining Work First)编码器调度策略,按剩余工作量最短优先原则批处理编码请求,避免大图阻塞小图,平滑解码器输入流;最后,开发基于资源利用曲线的动态分配运行时(Space Inference Runtime),离线构建资源-效用曲线,在线根据请求元数据动态分配SM计算单元,最小化端到端延迟。

在Qwen2-VL系列模型(2B–72B)上的实测数据显示,SpaceServe显著优于传统vLLMv1系统。当请求率增加时,vLLM的TPOT从101ms急剧恶化至365ms,而SpaceServe仅从8.85ms微增至12.62ms。根本原因在于,vLLM中编码器独占GPU时解码器无法推进,而SpaceServe通过空分复用使解码器在编码器运行期间持续生成token,彻底解耦了执行流程。

与NVIDIA MPS(Multi-Process Service)方案的对比进一步验证了SpaceServe的优势。在10 RPS(每秒请求数)条件下,MPS版本的TPOT为132ms,而SpaceServe通过细粒度SM分区将延迟降至40.68ms,提速3.3倍。这是因为MPS仅在进程级隔离资源,编码器与解码器仍会争抢同一SM内的寄存器、L1缓存等资源,导致缓存污染与执行效率下降。而SpaceServe通过SM级物理分区实现了真正的资源隔离,最大化各自执行效率。

这项研究无需修改现有模型结构,即可兼容Qwen2-VL、Kimi-VL等主流MLLM,且代码已开源,有望集成至vLLM、SGLang等框架,推动多模态服务的高效落地。值得注意的是,SpaceServe主要优化稳态吞吐(TPOT),对首token延迟(TTFT)影响有限,这与设计目标一致——聚焦于解码器的持续高吞吐,而非单次编码加速。

项目地址:https://github.com/gofreelee/SpaceServe