在人工智能领域,开源多模态模型长期面临复杂推理能力不足的困境,与GPT-4o、Gemini等闭源模型存在显著差距。这种差距并非源于模型架构或参数规模,而是高质量思维链密集型推理数据的严重匮乏。上海AI实验室OpenDataLab团队近期推出的MMFineReason框架,通过创新的数据合成方法,为破解这一难题提供了全新路径。

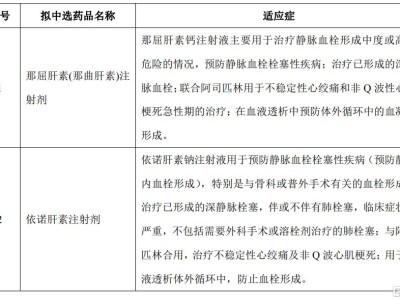

传统开源多模态数据存在两大核心缺陷:数据类型失衡与推理质量低下。现有数据集中,简单视觉问答(VQA)和自然图像占比过高,而STEM图表、逻辑谜题等高价值数据不仅稀缺,标注成本更居高不下。即便标注为"推理数据"的样本,也普遍存在推理链条简短、模板化严重、视觉与逻辑割裂等问题,难以支撑复杂推理任务训练需求。

MMFineReason框架构建了全流程开源的数据生产管线,包含标准化处理、推理蒸馏和双重过滤三大核心模块。在标准化阶段,研究团队对数学、几何、科学图表等八大领域数据进行统一建模,建立跨模态数据Schema。推理蒸馏环节采用Qwen3-VL-235B-Thinking作为教师模型,强制遵循"视觉感知-逻辑推导-中间验证-结论确认"的四阶段框架,生成包含2910个token平均长度的详细推理轨迹。

该框架最突破性的创新在于双重过滤机制。首先通过正确性过滤剔除答案与推理过程不一致的样本,随后实施难度感知过滤,专门筛选出Qwen3-VL-4B模型"稳定失败"的高挑战样本。这种精准的数据筛选策略,使得仅用7%(12.3万条)的高难度数据,就能达到与全量180万条数据相当的训练效果。

基于该框架训练的MMFineReason-4B模型展现出惊人性能,在复杂推理任务中超越Qwen3-VL-8B-Thinking,性能直逼参数规模大8倍的Qwen3-VL-30B-A3B-Thinking。更令人瞩目的是MMFineReason-8B模型,其表现不仅击败Gemini-2.5-Flash等商业模型,更开始挑战GPT5-mini-High等顶级开源模型。这种"以小博大"的性能跃迁,完全源于数据层面的结构化创新与推理密度提升。

研究团队构建的180万条高质量数据集具有显著领域特征:数学数据占比达79.4%,覆盖几何、微积分等深度学科;科学图表数据占13.8%,聚焦物理、化学复杂分析;谜题与游戏数据占4.6%,通过抽象模式识别挑战模型极限。这种高强度训练带来意外收获:模型在STEM领域的深度训练,反而提升了其在通用VQA任务中的表现,打破了专项训练削弱通用能力的传统认知。

该项目的开源内容包括完整数据集、训练代码和评估工具链。其中MMFineReason-1.8M为全量数据集,MMFineReason-586K剔除了简单样本,MMFineReason-123K则精选出最具挑战性的数据子集。这种分层设计既满足基础研究需求,也为工业应用提供了高效训练方案。项目已在Huggingface和GitHub平台全面开放,为多模态大模型发展注入新动能。