AIPress.com.cn报道

2月14日,字节跳动宣布豆包大模型正式进入2.0阶段。

这次发布的核心思路很明确:随着AI进入Agent时代,大模型不再只是回答问题,而是要在真实世界中执行复杂任务。豆包2.0围绕这个方向做了系统性优化,强化了高效推理、多模态理解和复杂指令执行三项核心能力。

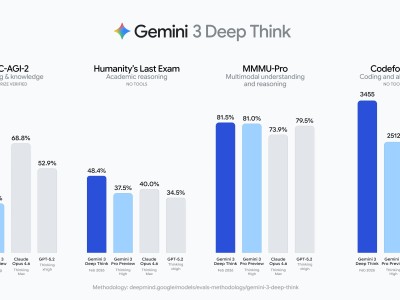

豆包2.0系列包含四款模型。Pro版面向深度推理和长链路任务,官方表态是全面对标GPT 5.2和Gemini 3 Pro。Lite版在性能和成本之间取平衡,综合能力超越上一代主力模型豆包1.8。Mini版面向低延迟、高并发和成本敏感的场景。Code版专门为编程场景优化,和字节自家的AI编程产品TRAE配合使用效果更好。

目前豆包2.0 Pro已经在豆包App、电脑端和网页版上线,用户切换到"专家"模式就可以体验。Code版已接入TRAE。面向企业和开发者,火山引擎也已经上线了全系列的API服务。

先看多模态能力。豆包2.0在视觉理解任务上的表现达到了全球顶尖水平,视觉推理、感知能力、空间推理和长上下文理解尤为突出。Pro版在大多数相关基准测试中拿到了最高分。

在动态场景理解方面也有明显进步。豆包2.0强化了对时间序列和运动感知的处理能力,在TVBench等关键评测中领先,在EgoTempo基准上甚至超过了人类得分。这意味着它对变化、动作、节奏这类时序信息的捕捉更加稳定,在实际应用中的可靠性更高。

长视频场景是另一个亮点。豆包2.0在多数长视频评测上超越了其他顶尖模型,在流式实时问答基准中表现也很好。实际应用场景包括实时视频流分析、环境感知、主动纠错和情感陪伴。举个例子,它可以在你健身或试穿衣服时实时提供反馈和建议,从被动问答升级为主动指导。

再看语言模型和Agent能力。要在真实世界执行长程任务,模型需要广泛而深入的知识储备。豆包2.0在长尾领域知识上做了重点加强。结果是,Pro版在SuperGPQA上的得分超过了GPT 5.2,在HealthBench上拿到了第一名,在科学领域的整体成绩与Gemini 3 Pro和GPT 5.2相当。

推理和竞赛方面的成绩也很亮眼。Pro版在IMO和CMO数学奥赛、ICPC编程竞赛中获得金牌成绩,在Putnam Bench上超过了Gemini 3 Pro。在HLE-text(被称为"人类的最后考试"的评测)上拿到了最高分54.2分。工具调用和指令遵循测试中也表现出色。

不过跑分之外,豆包2.0可能最具竞争力的一点是定价。官方表示,模型效果与业界顶尖水平相当,但token定价降低了大约一个数量级。在Agent时代,复杂任务的执行往往涉及大规模推理和长链路生成,会消耗大量token,成本差异在这种场景下会被急剧放大。便宜十倍意味着企业在相同预算下可以处理十倍的任务量,或者用十分之一的成本达到相同的效果。

Agent能力方面,字节展示了一个基于OpenClaw框架和豆包2.0 Pro构建的智能客服案例。这个客服Agent部署在飞书上,能通过调用不同技能完成客户对话。碰到自己解决不了的问题,它会主动拉群求助真人同事。它还能帮客户预约上门维修人员,维修完成后主动回访,顺便推荐春节优惠产品。整个流程不是预设的固定脚本,而是根据实际情况动态决策。

Code模型的演示同样值得一看。字节用TRAE加豆包2.0 Code搭建了一个叫"TRAE春节小镇·马年庙会"的互动项目。这个场景相当复杂:11个性格各异的NPC由大语言模型驱动,会根据人设自然聊天、招呼客人、现场砍价。AI游客们像真人逛庙会一样,自己决定去哪个摊位、买什么、说什么。烟花升空时的祝福语、孔明灯上的四字题词都由AI实时生成,每次进入小镇看到的互动都不一样。

整个项目只用了一轮提示词完成基础架构和场景搭建,再经过几次调试,总共五轮提示词就完成了。相关的提示词和素材已经开源在GitHub上。