NVIDIA近日正式发布了CUDA 13.1版本,官方称其为自2006年CUDA平台问世以来最具突破性的全面升级。此次更新最引人注目的创新是引入了基于数据块(Tile)的编程模型,将GPU编程范式推向更高层次的抽象阶段。

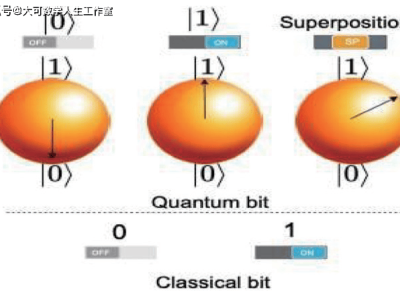

传统GPU开发依赖单指令多线程(SIMT)架构,开发者需要手动管理线程分配、内存访问和同步机制等底层细节。而新推出的CUDA Tile模型允许开发者以数据块为单位组织计算任务,编译器和运行时系统会自动处理线程调度、内存优化和硬件资源映射等复杂操作。这种转变显著降低了开发门槛,使非专业GPU程序员也能高效利用硬件加速能力。

为支撑新编程模型,CUDA 13.1同步推出了虚拟指令集Tile IR和配套开发工具cuTile。开发者现在可以通过Python直接编写GPU内核代码,无需掌握传统的CUDA C/C++或SIMT编程范式。这种高层抽象设计特别适合数据科学家和科研人员,他们可以更专注于算法逻辑而非硬件细节。

值得关注的是,Tile编程并非要取代现有SIMT模式,而是提供并行开发的替代方案。开发者可根据应用场景特点,在两种编程模型间自由选择。例如,需要精细控制硬件资源的场景可继续使用SIMT,而数据密集型计算则更适合Tile模型。

技术架构层面,CUDA 13.1通过引入Tile IR和增强型抽象层,在硬件与软件之间构建了更厚的技术栈。这种设计不仅为开发新一代跨架构计算库奠定基础,更形成了显著的技术壁垒。竞争对手若要兼容CUDA Tile特性,必须重新开发具备同等智能水平的编译器,这远非简单的代码转译所能实现。

行业分析指出,此次升级将进一步强化NVIDIA在GPU计算生态中的主导地位。更高层次的抽象设计使得用户迁移成本大幅增加,既有的CUDA代码库和开发经验成为难以替代的核心资产。对于AMD ROCm和Intel OneAPI等竞争平台而言,要实现功能对齐将面临前所未有的技术挑战。