人工智能领域迎来重大突破,阿里巴巴Qwen团队推出的Qwen3-VL视觉语言模型引发行业关注。这款模型突破传统AI的局限,不仅能同时处理文字、图像和视频信息,还能理解长达25万词的文档内容,甚至具备根据界面截图生成代码的实用能力。其核心优势在于实现了真正意义上的多模态融合,让AI像人类一样自然地整合视觉与文本信息。

在技术架构层面,研究团队创新性地设计了三大核心组件。增强版位置编码技术通过交错MRoPE机制,将时间、空间信息均匀混合处理,显著提升视频理解能力;DeepStack融合机制打破传统视觉与语言模块的独立运作模式,实现多层次深度协作;基于文本的时间对齐技术采用简洁的场景标签系统,使模型能直观把握视频时间结构。这些创新使模型在处理复杂场景时展现出卓越的推理能力。

模型训练体系采用四阶段渐进式培养方案。初始阶段通过670亿图文样本建立基础对应关系,随后在1万亿词汇的多模态数据中拓展能力边界。第三阶段专门强化长文本处理,将输入长度扩展至32768词,最终阶段更是突破至256K词汇量级。后训练阶段引入双版本微调策略,非思维版本注重响应速度,思维版本则展示完整推理链条,满足不同场景需求。

数据构建工程堪称AI领域的"百科全书计划"。研究团队不仅重新撰写了更精准的图像描述,还构建了涵盖13个语义类别的大规模知识库。在OCR领域将支持语言从10种扩展至39种,文档解析任务收集300万份多语言PDF样本。特别开发的自动化标注流水线,通过三级质量把控机制生成高精度物体标注数据,为模型训练提供坚实基础。

性能验证显示突破性成果。在MMStar测试中,2350亿参数版本取得78.7分,与顶尖模型差距微小;MMBench测试中非推理模式以89.3分领跑。数学视觉推理领域表现尤为突出,在MathVista等测试中多次刷新纪录。中等规模32B版本在多项基准测试中超越Gemini-2.5-Flash,展现卓越的规模效应。多语言OCR支持39种语言,其中32种语言准确率超70%。

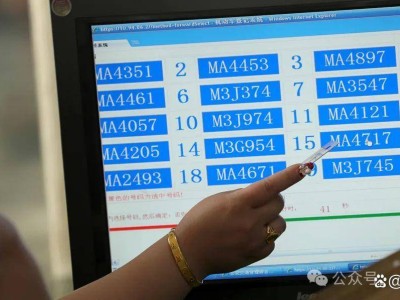

实际应用场景展现惊人潜力。在多图像理解任务中,模型能同时分析多张监控画面间的关联性;空间理解测试中准确识别物体三维位置与功能属性;视频理解能力使80亿参数版本达到前代720亿参数模型的性能水平。智能代理测试中,320亿参数版本在移动端界面操作任务取得63.7分,超越多数基础模型。代码生成能力支持从网页截图直接生成HTML/CSS,甚至能将流程图转化为可执行代码。

技术影响力辐射整个AI生态。该模型重新定义了长文本处理标准,其256K上下文窗口在"针海捞针"测试中实现100%准确率,扩展至100万token时仍保持99.5%精度。多版本架构设计提供灵活解决方案,从轻量级2B版本到旗舰级235B版本,满足不同场景需求。研究团队选择开源策略,完整模型家族采用Apache 2.0协议发布,为全球开发者提供基础技术支撑。

这项突破引发行业深度思考。超强代码生成能力可能重塑软件开发流程,文档理解技术或将改变知识管理方式。研究团队特别强调,模型在保持多模态优势的同时,文本处理能力达到专业模型水准,这种均衡发展模式为通用人工智能研究提供新思路。完整技术细节已通过学术论文公开,为后续研究提供重要参考。