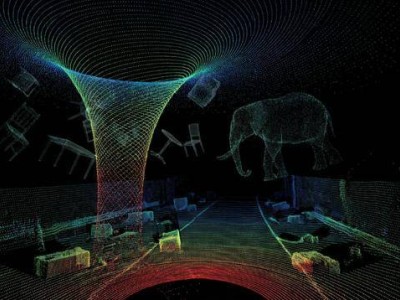

AI大模型自问世以来,"幻觉"问题始终如影随形。这种技术特性源于其底层设计逻辑——为保证交互连续性,系统必须对所有提问给出回应,即便面对无法处理的复杂问题时,也可能生成看似合理却荒谬的内容。Listenhub运营总监马克斯指出:"当前技术架构决定了无法彻底消除幻觉,只能通过工程手段降低发生频率。"这种困境正演变为一场技术攻防战:开发者不断加固安全防线,用户则持续寻找系统漏洞,形成类似早期互联网时代的"猫鼠博弈"。

内容生产领域正经历颠覆性变革,但AI幻觉带来的风险日益凸显。近期某国际知名聊天机器人因生成大量涉及未成年人的色情伪造内容,遭到法国、马来西亚、印度三国监管部门联合问责。印度电子信息技术部特别要求社交平台限制该模型传播违法信息,马斯克回应称将追究内容生成者的法律责任。这类事件暴露出技术失控的潜在危害,深圳大学安全领域专家分析称:"现有模型本质是概率预测系统,在计算能力受限的情况下,为保证输出流畅性可能牺牲准确性。"

技术缺陷与人为干预的双重作用,导致AI幻觉呈现多样化形态。某大模型工程师透露,开发阶段会为系统设置"人格防火墙",通过预设禁止性规则过滤违规内容。但用户可通过特定指令暂时绕过这些限制,这种突破常规输出的现象被视为新型幻觉表现。汇正财经顾问冯涛指出,数据质量缺陷和逻辑推理不足是两大根源:"训练数据中的错误信息会像病毒般传播,而复杂知识关联的建模漏洞则可能引发系统性偏差。"

应对策略正从单一防护转向综合治理。检索增强生成技术成为行业新宠,该技术通过外接知识库进行二次验证,显著提升专业领域输出的准确性。医疗、金融等行业已率先应用这项技术,但马克斯坦言:"在海量内容面前,完全杜绝异常输出仍不现实。"更严峻的挑战来自法律界定模糊区,当生成内容引发纠纷时,责任主体是开发者、使用者还是平台方,目前尚无明确判定标准。

监管框架正在加速完善。我国2023年实施的《互联网信息服务深度合成管理规定》要求对深度合成内容做显著标识,2025年新出台的《人工智能生成合成内容标识办法》进一步建立双轨标识制度。法律专家孟博强调,根据《生成式人工智能服务管理暂行办法》,服务提供者需承担内容审核主体责任,发现违法信息必须立即采取停止生成、优化模型等整改措施。新修订的《网络安全法》也增设人工智能伦理规范条款,为技术治理提供法律依据。

AI生成内容规模已达惊人程度。据Graphite公司统计,截至2025年5月,英文互联网中AI生成内容占比达52%,这个数字仍在快速增长。这种爆发式增长催生出新的文化现象——韦氏词典将"slop"(原指残羹剩饭)选为年度词汇,用以形容低质量AI生成内容。律师孟博认为,这个选择折射出社会对技术伦理的深层思考:"在享受技术红利的同时,必须通过制度设计确保其符合人类价值观。"