在人工智能技术持续突破的背景下,多模态大语言模型已从单一文本处理向图文协同理解演进。然而这类系统在执行学术研究任务时的真实表现,特别是能否像专业研究者般完成资料收集、证据分析和引用规范的研究报告撰写,始终缺乏系统性评估。近日,由国际多所顶尖高校与科技企业联合完成的研究,首次构建了针对深度研究代理(DRA)的综合性评测体系,为评估AI学术能力提供了新维度。

研究团队开发的MMDeepResearch-Bench评测平台(简称MMDR-Bench),设计了覆盖21个学科领域的140个专家级任务。这些任务分为日常信息处理和学术研究两大类,前者涉及产品说明解析、健康图表解读等场景,后者则包含科学图表分析、技术原理图阐释等复杂任务。每个任务均由博士级专家设计,确保需要同时处理文本与视觉信息,且所有结论均可通过引用验证。

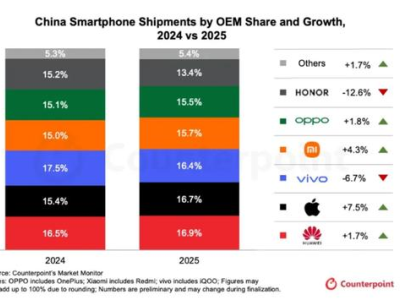

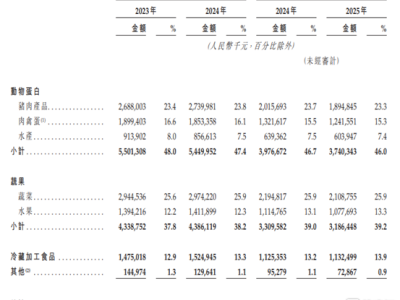

在对25个主流AI系统的测试中,Gemini深度研究系统以49.41分(满分100)领跑,其优势体现在证据质量和引用对齐能力。值得注意的是,不同模型在能力维度上呈现显著差异:部分系统文本生成流畅但引用混乱,另一些虽能精准引用却难以处理复杂图表。研究特别指出,添加视觉处理模块未必提升性能,某些模型在读取表格数字、日期标签等细节时错误率反而上升,暴露出当前视觉理解技术的局限性。

评测发现多模态整合与引用严谨性存在矛盾:某些系统能准确关联图文信息,但引用规范不足;专业研究代理虽擅长多步骤验证,却常在实体识别环节出错。研究还揭示,模型性能提升的关键不在于规模扩张,而在于基础架构优化与检索交互设计。部分离线模型因检索策略高效,甚至超越了具备网络搜索能力的模型。

为验证评估可靠性,研究团队邀请12位领域专家进行独立评审。结果显示,完整评估框架与专家判断的一致性达73.5%,相关性达96.4%,显著优于传统提示词评估方法。这表明该体系能较准确地反映AI系统的真实研究能力。

Q&A环节中,研究团队解释了MMDR-Bench的独特价值:该平台通过标准化任务设计,首次实现了对AI学术研究能力的全流程评估。针对视觉能力反降性能的现象,团队指出当前模型在处理微小文字、复杂排版等视觉细节时仍存在技术瓶颈。对于用户使用建议,专家强调应建立"人机协作"机制,将AI定位为信息筛选工具而非最终决策者。