近期,字节跳动推出的新款视频生成模型Seedance 2.0引发了广泛关注,其生成的视频效果在各类工作群和社交平台上引发热议。这款模型凭借出色的视频生成能力,迅速成为焦点。

Seedance 2.0展现出的视频效果令人惊叹。无论是生成美少女亲切打招呼的画面,还是让两个老头在屋内激烈打斗的场景,都能轻松实现。甚至只需上传同事的照片,它就能生成一段包含自然语音的天气预报口播视频,声音与画面完美匹配。即使输入一道数学题,它也能尝试手写解答,尽管答案可能有误,但语音部分依然准确无误。

与以往的视频生成模型相比,Seedance 2.0在多个方面实现了显著提升。人物一致性、动作流畅性和音频适配性都达到了新的高度,视频质量有了质的飞跃。许多用户在长时间使用后,甚至开始难以分辨视频内容的真假。

Seedance 2.0的强大之处不仅在于其基础能力,更在于其独特的分镜功能。传统AI视频模型往往只能生成固定机位的画面,而Seedance 2.0能够自动实现多镜头切换。例如,在生成东方明珠塔攻击蜜雪冰城雪王的视频时,短短五秒内镜头切换四次,从远景到特写,再到全景展示,节奏紧凑、逻辑清晰,使视频更具观赏性和情绪感染力。

这一功能的实现,大大降低了视频创作的门槛。过去,用户需要预先构思每个分镜,生成大量关键帧,再通过剪辑才能完成视频制作。而现在,Seedance 2.0能够自动完成这些工作,将原本复杂的过程简化为一句提示词,让新手也能轻松上手。

除了分镜功能,Seedance 2.0在音效和配音方面也表现出色。无论是光之巨人与怪兽的嘶吼声,还是夜之城飙车的引擎轰鸣声,都能精准还原。用户还可以在提示词中指定视频中的语音内容,甚至上传自己的声音作为音色参考。

在产品设计上,Seedance 2.0同样表现出色。它通过即梦平台(jimeng.jianying.com)提供服务,用户只需选择“视频生成”模式,切换至“全能参考”或“首尾帧”模式,即可使用最新模型。即使没有内测资格,用户也可以通过小云雀App或等待火山引擎发布API后,在更多平台上体验。

“全能参考”模式是Seedance 2.0的一大亮点。它允许用户从图片、视频、音频和文本四个维度描述需求,最多可同时输入9张图片、3个视频和3个音频文件。例如,用户只需上传同事的照片和一段舞蹈视频,就能生成一条包含自然面部轮廓的舞蹈视频,无需详细描述舞蹈动作、音乐或服装。

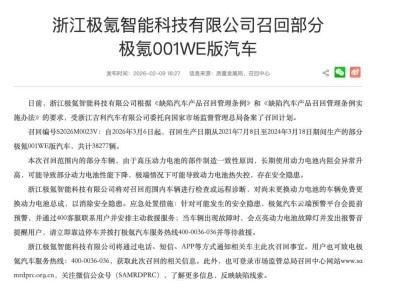

然而,随着AI视频生成技术的普及,一些问题也逐渐浮现。由于生成视频的门槛降低,越来越多的人可能难以分辨视频内容的真假。例如,有用户制作了一段“自己送外卖”的视频发到家族群,结果母亲信以为真,引发了一场虚惊。

这一现象引发了对技术伦理的关注。尽管字节跳动在Seedance 2.0中加入了一些自我约束机制,例如对真人照片的屏蔽功能,但这些措施尚不稳定。技术进步的同时,如何保护用户免受误导,成为亟待解决的问题。

对于普通用户而言,AI视频生成工具不仅是一种创作手段,更是一种需要谨慎使用的技术。在享受技术带来的便利时,也应意识到其可能带来的风险,尤其是对信息辨别能力较弱的群体。