近日,人工智能领域再度迎来重要更新,DeepSeek官方悄然发布了其最新版本的模型——DeepSeek-V3.1。这一消息迅速在网络上发酵,仅仅一个小时内,在某社交平台上的浏览热度便飙升至26万,彰显了业界与公众的高度关注。

据悉,DeepSeek-V3.1是一款集思考模式与非思考模式于一体的混合型模型。用户可以根据实际需求,灵活切换这两种模式,从而在推理深度与效率之间找到最佳平衡点。这一创新设计,得益于DeepSeek团队对训练策略的深度优化以及对大规模长文档处理的拓展,使得新模型在推理速度、工具调用智能、代码及数学任务处理等方面均实现了显著提升。

DeepSeek-V3.1的亮点纷呈。首先,其混合思考模式允许单一模型通过对话模板的切换,兼容思考与非思考两种状态,大大提升了模型的适用性和灵活性。其次,经过后训练优化的模型,在调用工具和完成智能体任务方面的表现有了质的飞跃。再者,新模型在回答质量上可与业界领先的R1-0528相媲美,同时响应速度更快,展现了更高的思考效率。

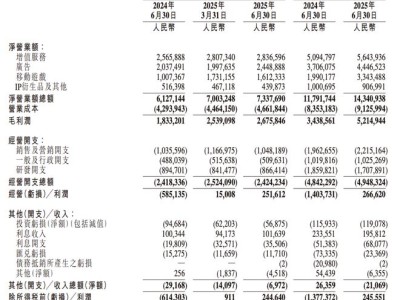

官方公布的测试结果显示,DeepSeek-V3.1在多个基准测试中均优于前代模型R1-0528。例如,在美国数学邀请赛2025版(AIME 2025)中,新模型得分88.4%,高于R1-0528的87.5%;在高难度研究生级知识问答数据集Diamond子集(GPQA Diamond)中,得分80.1%,同样优于R1-0528的81.0%;在实时编码基准(LiveCodeBench)中,得分74.8%,较R1-0528的73.3%有所提升。尤为新模型在输出tokens数大幅减少的情况下,仍保持了相似或略高的准确率,显示出在计算资源优化方面的显著优势。

DeepSeek-V3.1在软件工程和智能体任务基准上的表现同样抢眼。在SWE-Bench Verified测试中,新模型得分66.0%,远高于R1-0528的44.6%,表明其在处理复杂代码任务时的可靠性显著提升。在多语言版本SWE-Bench Multilingual测试中,DeepSeek-V3.1得分54.5%,大幅领先R1-0528的30.5%,显示出其在多语言支持方面的显著进步。而在Terminal-Bench测试中,新模型得分31.3%,优于R1-0528的5.7%,表明其在智能体框架下的效率有了大幅提升,适合自动化运维或DevOps应用。

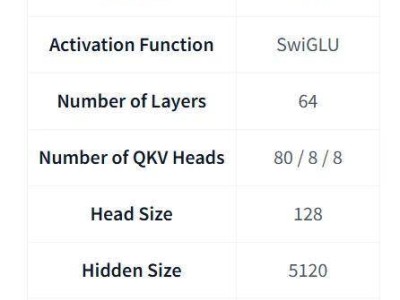

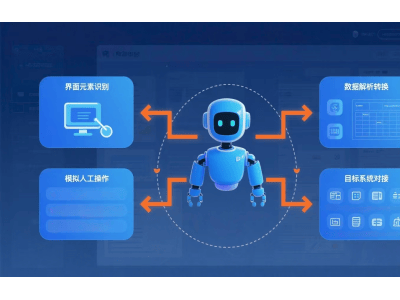

此次更新,DeepSeek-V3.1的核心在于显著增强了模型的智能体能力,特别是在复杂推理和工具链协作场景下的实际表现。同时,新模型在搜索Agent、长上下文理解、事实问答和工具使用等领域的性能也表现出色。基于MoE架构的DeepSeek-V3.1(总参数671B,激活37B)在大多数基准上显著优于R1-0528,尤其在搜索Agent和长上下文任务上的提升尤为显著,平均提升约20-300%。这意味着新模型更适合构建AI Agent应用,如自动化搜索或代码辅助。

在Huggingface平台上,DeepSeek释放了更详细的评估结果。结果显示,DeepSeek-V3.1在常规推理和知识问答任务上的整体表现稳定提升,非思考和思考模式下的分数均高于V3旧版,基本接近行业顶尖大模型水平。例如,在Humanity’s Last Exam(搜索+Python复合推理)任务上,新模型实现了29.8%的通过率,优于R1-0528的24.8%,并接近GPT-5、Grok 4等国际一线大模型。

除了性能上的显著提升,DeepSeek-V3.1的价格策略也备受瞩目。此次发布的新模型,在输入定价上分为缓存命中和缓存未命中两种情况,分别为0.07美元/百万tokens和0.56美元/百万tokens,输出定价为1.68美元/百万tokens。这一价格策略被认为极具竞争力,引发了业界的广泛讨论和好评。

DeepSeek-V3.1还首次实现了对Anthropic API的原生兼容。这意味着用户可以将DeepSeek无缝集成到现有系统中,无论是通过Claude Code工具链还是直接使用Anthropic官方SDK,开发者只需简单配置API地址和密钥,即可在所有支持Anthropic API的环境下,享受DeepSeek-V3.1提供的强大推理和对话能力。