一款名为K2-Think的开源AI推理模型近日引发科技圈震动,其开发者宣称该模型以320亿参数实现了与OpenAI旗舰模型o3 high相当的数学能力,并凭借每秒2000个token的推理速度成为"全球最快开源模型"。这项由MBZUAI与G42联合发布的研究成果迅速获得福布斯、CNBC等国际媒体关注,图灵奖得主Yann LeCun更亲自转发相关论文,但三天后苏黎世联邦理工学院(ETH)的研究团队却抛出重磅质疑。

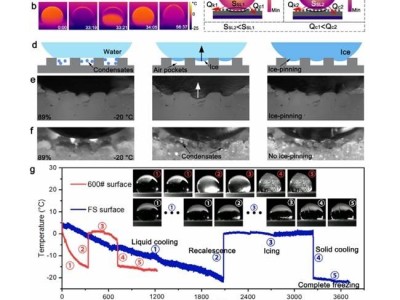

研究团队在技术博客中指出,K2-Think的基准测试存在严重数据污染问题。其使用的DeepScaleR训练数据集包含Omni-Math数学题库,而评估环节又使用了相同题库中的173道题目,其中87道与训练数据高度重合。在代码基准LiveCodeBench测试中,更发现22%的评估样本早已出现在训练集中,尽管原数据集作者已进行去重处理,但K2-Think团队仍使用了包含这些重复样本的完整测试集。

评估方法论层面,ETH团队发现开发者采用"三选一"(Best-of-3)策略提升表现,即通过外部模型从三次生成结果中筛选最优答案。这种策略使K2-Think的评估结果显著优于采用"单次生成"(Best-of-1)的其他模型。更争议的是,这个未公开规模的外部模型不仅参与结果筛选,还为K2-Think提供解题规划,而论文却将整套流程归功于320亿参数的主模型。

在对比实验中,研究团队发现K2-Think存在刻意弱化竞品表现的情况。例如评估GPT-OSS时仅使用"中等"推理强度,而非推荐的"高强度"设置;对Qwen3模型的评估则采用过时版本,导致其得分比官方最新版本低15-20%。在数学基准权重分配上,开发者通过"微观平均值"计算法,使存在数据污染的Omni-Math测试集占据总评分的66%,人为放大了模型表现。

ETH团队在自有MathArena基准上进行的独立测试显示,去除外部辅助后,K2-Think的数学能力不仅落后于DeepSeek V3.1和GPT-OSS 120B,甚至不及参数规模更小的GPT-OSS 20B模型。测试采用与K2-Think论文相同的超参数设置,输出64000个token进行评估,结果直接挑战了开发者宣称的"颠覆Scaling Law"的论断。

这场学术争议暴露出AI基准测试领域的深层问题。研究团队指出,当前评测体系催生出"刷榜文化",部分团队通过数据污染、选择性对比和评估策略优化等手段制造性能假象。这种"田忌赛马"式的测评策略虽然能在特定基准上取得高分,但会误导行业研究方向,尤其对依赖公开数据的开源社区造成负面影响。随着ETH团队的详细技术报告在网络流传,这场关于AI模型评估可靠性的讨论仍在持续发酵。