面壁智能与清华大学深圳国际研究生院人机语音交互实验室(THUHCSI)联合研发的语音生成基座模型VoxCPM正式开源,其参数规模仅为0.5B,已在GitHub、Hugging Face等平台向全球开发者开放。这款端到端扩散自回归模型突破了传统语音合成技术路径,通过融合层次化语言建模与局部扩散生成架构,实现了从文本到连续语音表征的高效转换。

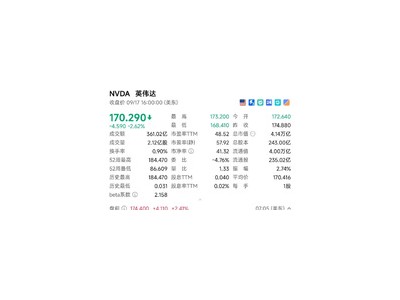

区别于CosyVoice、FireRedTTS等采用离散声学词元处理的方案,VoxCPM创新性地采用连续表征端到端TTS技术。该模型可直接解析输入文本,实时流式生成高质量音频片段,在单张NVIDIA RTX 4090显卡上实现RTF≈0.17的推理速度。权威评测显示,其在Seed-TTS-eval榜单的相似度、词错误率等核心指标均达到行业顶尖水平。

模型具备强大的文本理解能力,可自主适配不同场景的语音特征。无论是模拟天气预报员的规范播报、历史英雄的激昂演讲,还是还原方言主播的特色腔调,均能通过调整韵律参数实现精准还原。特别在中文处理方面,模型突破性地支持数学公式、特殊符号的语音合成,同时提供音素级标记替换功能,允许用户自定义读音修正。

技术团队介绍,VoxCPM通过扩散生成机制与语言模型的深度耦合,显著提升了语音输出的自然度与稳定性。其流式输出能力理论上支持无限长度音频的实时生成,为智能客服、有声读物、教育辅导等场景提供了新的技术解决方案。目前开源版本已包含完整的训练代码与预训练权重,开发者可基于现有框架进行二次开发。