视频生成领域迎来新突破,可灵近日发布可灵O1模型,同时推出可图O1、音画同出模型可灵2.6、可灵数字人2.0以及可灵O1主体库&对比模版五项更新。此次核心亮点在于两个O系列生成模型,其“O”代表Omni(all,一切),意味着模型不再局限于单一模态输入,可灵O1更被视为视频生成界的“Nano Banana”,二者均具备多模态整合、强可控性和多轮编辑能力。

可灵的野心不止于打造又一个视频模型,梳理其近一年动作可知,O系列或许只是开端,未来方向是构建世界模型。早在2024年12月,首个火爆的视频生成模型Sora宣称自己是“世界模拟器”,此后众多视频生成模型在宣传或研究上逐渐向“世界模型”靠拢,可灵也不例外。

从论文线索来看,快手在相关技术演进上早有布局。2024年12月Sora公开上线当月,快手就发布论文《Owl-1: Omni World Model for Consistent Long Video Generation》,提出Omni World Model(Owl-1),用于实现持续长视频生成并预测未来动态。进入2025年,可灵团队密集发布世界模型相关研究,紧跟行业关键节点。例如2025年8月Google发布实时交互的Genie3后,快手对其在游戏领域的应用展开研究,论文获ICCV 2025 Highlight;2025年11月李飞飞发布3D“世界模型”,快手也有对应模型Terra。

然而,“世界模型”概念被炒热的同时,也引发争议。图灵奖得主Yann LeCun认为视频生成不等于世界模型,单纯预测下一个像素点只是对画面模仿,并非真正理解物理世界。对此,可灵团队在2025年11月发布论文《Simulating the Visual Visual World with Artificial Intelligence: A Roadmap》回应,称视频生成模型可学习物理规律,像素是模型渲染给人类看的结果,不代表中间没有计算和推理。该论文还为“视频生成模型如何通往世界模型”画出路线图,将Kling 1.0归类为第一代世界模型,Kling2.1 Master归类为第二代世界模型。在他们看来,现代视频模型并非直接预测像素,而是存在隐式世界模型在高维潜在空间进行推演,与LeCun的潜在空间推理同理,接收当前状态输入,基于推理能力和内化物理法则计算下一时刻世界状态。

可灵近期研究围绕世界模型展开。在《Simulating the Visual World with Artificial Intelligence: A Roadmap》中,团队认为“视频生成”走向“世界模型”的关键是导航模式。真正的世界模型不能仅靠“空间条件”描摹画面,必须能听懂“导航条件”,即具有时序和空间推理的交互指令。为此,团队在“导航条件”研究上投入颇多。镜头运动是导航条件之一,ICCV高分论文RecamMaster提出摄像机控制生成视频重渲染框架,能在新摄像机轨迹下再现输入视频动态场景;SynCamMaster让模型在同一时间轴实现多摄像机视频生成,确保不同视角内容一致;AdaViewPlanner让AI成为摄影指导,自主规划最佳观察路径。这些研究提升了模型对3D、4D空间的动态感知,也体现在此次O系列中,如可灵O1能针对侧面车内驾驶视频生成后座视角视频,可图O1可将二维房间设计图转化为三维空间设计图。按照快手路线图,可灵O1处于世界模型第二代到第三代之间,第二代特征是交互性,第三代核心是“规划能力”与“实时交互”,强化导航模式后模型不仅能“听指令走路”,还能基于物理知识自主推演生成无限长视频序列。

除导航类研究,快手还构建物理、推理方向研究。推出的Monet训练框架,通过让多模态大语言模型(MLLMs)在连续潜在视觉空间推理,增强视觉推理能力;PhysMaster作为模型外挂,通过注入物理知识增强视频生成模型物理感知能力,使其生成更符合物理规律的视频。

若快手继续向世界模型前进,实时性是关键卡点。尽管O1模型在空间逻辑、指令遵循上有进步,但生成5秒视频仍需约2分钟。从可灵1.0到2.1 Master的迭代中,团队采取“画质优先,速度让位”策略。但对于模拟世界的系统,无法实时响应更像“离线渲染器”。不过,在论文《Context as Memory: Scene-Consistent Interactive Long Video Generation with Memory Retrieval》中,团队埋下伏笔,随着“上下文压缩”技术改进,视频生成时间有望降低。

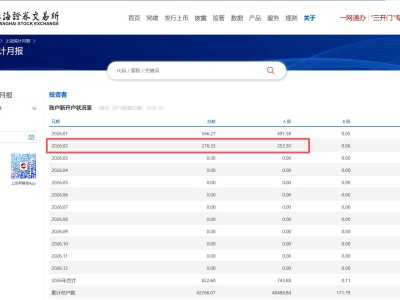

当前,Sora和可灵在发展路径上呈现“错位”。Sora最初喊出“世界模拟器”口号,如今却更像产品经理,忙着开发AI视频版TikTok和Cameo等娱乐玩法,向应用层发展;可灵虽有一系列研究,对外产品公布却未提世界模型。这背后是商业考量,在11月19日Q3财报会上,程一笑提到视频模型与大语言模型均朝世界模型演进,视频模型有望成为核心技术支撑,但可灵现阶段核心目标是“AI影视创作场景”。可灵产品和模型分离,平台是核心输出产品,其营业收入主要由P端付费用户(专业自媒体、视频创作者和广告营销从业者等)和企业客户API服务构成,近70%由P端付费用户贡献。这群“金主”更关注能否稳定出片、能否赚钱,对是否为“世界模拟器”和实时性要求不高,因此可灵宣称自己是世界模型似乎无额外增益。

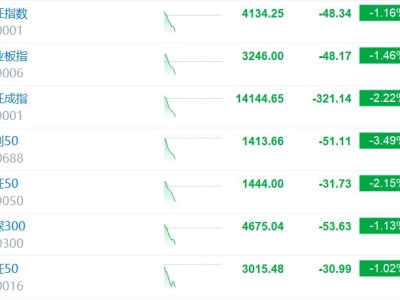

然而,单纯作为“影视创作工具”商业天花板明显。根据Q3数据,可灵AI今年第一、二、三季度收入分别超1.5亿元、2.5亿元、3亿元,全年预计收入1.4亿美元,但增速放缓。谷歌Veo3用于机器人领域、特斯拉利用生成式视频训练自动驾驶、游戏行业对AI引擎的渴求,表明具身智能、自动驾驶、游戏引擎等领域才是视频生成模型真正的发展方向,对模型物理一致性和实时交互能力要求极高。因此,对视频生成模型而言,成为“世界模型”至关重要,只有模拟真实,才能挖掘与物理世界交互的金矿。