百度近日正式推出并上线了其原生全模态大模型文心5.0,标志着人工智能技术迈向新的里程碑。这款模型拥有高达2.4万亿的参数规模,采用创新的原生全模态统一建模技术,能够同时处理文本、图像、音频和视频等多种信息形式,实现了跨模态的深度理解与生成能力。

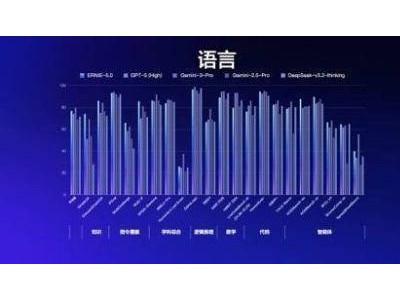

与市场上常见的“后期融合”多模态方案不同,文心5.0通过统一的自回归架构,将不同模态的数据在同一模型框架内进行联合训练。这种技术路线使得多模态特征能够在统一架构下充分融合,从而实现了原生的全模态理解与生成能力。在权威基准评测中,文心5.0的语言与多模态理解能力已超越Gemini-2.5-Pro、GPT-5-High等国际领先模型,稳居全球第一梯队。

文心5.0不仅在技术上取得突破,还在模型效率上进行了优化。其采用超大规模混合专家结构,激活参数比低于3%,在保持强大能力的同时显著提升了推理效率。通过大规模工具环境合成长程任务轨迹数据,并采用端到端多轮强化学习训练,模型的智能体和工具调用能力得到显著提升。

在应用层面,百度构建了以文心基础大模型为核心的矩阵模型和专精模型体系。矩阵模型面向通用场景快速落地,包括文心Lite模型、视频大模型和语音大模型;专精模型则针对行业应用和垂直场景,如搜索闪电专精模型、电商蒸汽机模型等。这些模型共同构成了百度AI应用的生态闭环。

百度应用模型研发部负责人贾磊在发布会上分享了文心应用模型的最新进展。他强调,模型的价值在于应用,而非模型本身。百度致力于让模型在真实场景中“跑得稳、答得对、用得起”。为此,百度推出了三项技术突破:基于声音Token的端到端合成大模型、5分钟超越真人的直播技术,以及实时交互数字人技术。

其中,实时交互数字人技术采用三态Token联动架构,实现了文本、语音、视频的流式控制。这一技术突破了传统数字人三个模态串联的制作模式,通过系统自动完成动作衔接、编排与状态重组,并由声音Token实时驱动表情与口型,输出三态合一的视频流。百度罗永浩数字人便是基于这项技术开发,具有低延迟、低成本和高表现力的特点。

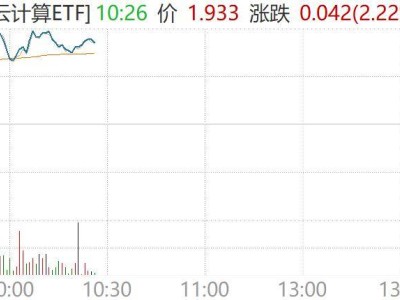

为了推动大模型在产业中的落地,百度千帆平台提供了全周期、稳定支持多场景业务的运行环境。平台集成文心5.0及全场景150+SOAT模型服务,并配备百度AI搜索等工具及MCP和Agent工具链,结合数据管理和企业级服务,显著降低了企业Agent创新门槛。目前,千帆平台上已累计开发超130万个Agents,工具日均调用量突破千万次。

百度凭借其“芯云模体”全栈自研生态闭环,正持续探索AI赋能行业的解决方案。从芯片到智能云,再到模型支撑的各类智能体应用,百度正以技术实力推动AI在真实世界与行业中的广泛应用。