谷歌在大模型领域再掀波澜,正式推出Gemini 3系列中速度最快、性价比最优的Gemini 3 Flash。这款新模型不仅延续了前代在复杂推理、多模态理解等领域的突破性表现,更在性能与效率之间实现了前所未有的平衡,部分指标甚至超越了旗舰级产品Gemini 3 Pro。

根据官方披露的评测数据,Gemini 3 Flash在编程能力基准测试SWE-bench Verified中取得78%的优异成绩,不仅领先于自家旗舰Gemini 3 Pro,更超越了Anthropic的Claude Sonnet 4.5。在多模态理解测试MMMU-Pro中,该模型以81.2%的得分力压GPT-5.2(79.5%)和Claude Sonnet 4.5,展现出强大的跨模态处理能力。这些突破性表现打破了传统认知中轻量化模型"速度快但性能弱"的固有印象。

谷歌CEO桑达尔·皮查伊特别强调,Gemini 3 Flash通过技术创新突破了帕累托极限,在保持智能水平的前提下,速度较前代旗舰2.5 Pro提升3倍,同时成本显著降低。具体定价显示,该模型输入费用为0.5美元/百万Tokens,输出费用3美元/百万Tokens,仅为Claude Sonnet 4.5(15美元)和GPT-5.2(14美元)的1/5左右。

技术层面,Gemini 3 Flash引入动态思维时长调节机制,可根据任务复杂度自动优化处理时间。测试表明,在典型工作负载下,其平均令牌使用量较2.5 Pro减少30%,却能更精准地完成日常任务。这种设计使其在保持旗舰级性能的同时,特别适合需要快速响应的交互场景。

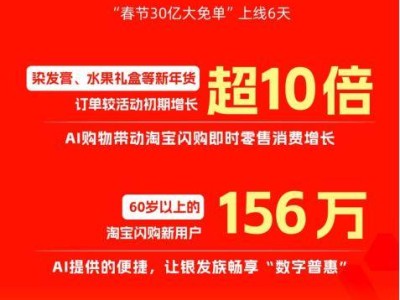

开发者实测数据进一步验证了其优势。在与GPT-5 Mini、DeepSeek-V3.2的Python代码生成对比中,Gemini 3 Flash以9秒完成测试,速度分别是后两者的3.9倍和4.6倍,且生成质量更优。独立开发者群体对此反响热烈,认为该模型将大幅降低AI应用开发成本,预计从GPT-4o或Gemini 3 Pro迁移后,运营成本可降低50%-70%。

从即日起,Gemini 3 Flash将全面开放使用,免费用户也可通过Gemini App直接体验。原2.5 Flash模型将逐步退出,Gemini 3 Pro则继续作为专业版,为高难度数学和代码问题提供深度支持。这种产品矩阵调整,显示出谷歌在通用人工智能领域构建多层次生态的战略意图。

值得关注的是,这是谷歌近一个月内在大模型领域的第四次重大更新。此前推出的Gemini 3 Pro和Gemini 3 Deep Think已获得市场广泛认可,内部API日均处理量突破1万亿Tokens。用户场景涵盖代码模拟、复杂主题学习、交互式游戏开发及多模态内容理解等多个领域。新发布的Flash版本凭借极致性价比,有望进一步扩大其开发者生态影响力。

据内部数据,前代Flash 2和2.5版本已支撑起数百万开发者构建的数十万应用,日均处理量达数万亿Tokens。这种规模化应用验证了轻量化模型的技术可行性,也为Gemini 3 Flash的快速普及奠定了基础。随着新模型全面上线,谷歌与OpenAI在通用人工智能领域的竞争将进入白热化阶段。