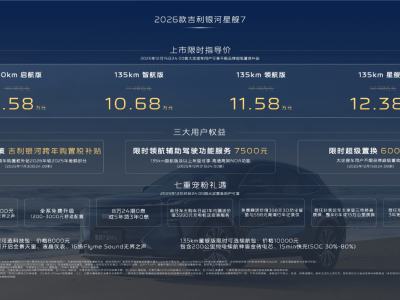

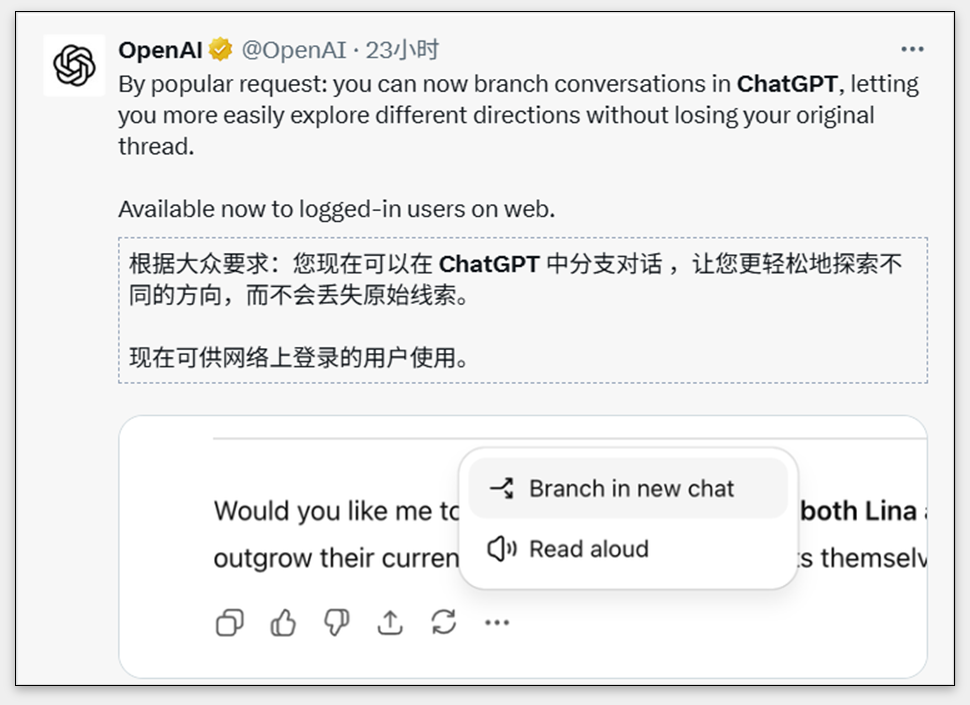

OpenAI近期为ChatGPT引入了一项名为“分支对话”的新功能,用户通过网页端操作即可在既有对话中创建新的分支路径。这一设计突破了传统对话的线性模式,允许用户在特定节点衍生出独立对话,无需新建聊天窗口或手动整理冗长历史记录。

结合此前上线的记忆功能,ChatGPT形成了独特的“记忆+分支”组合:记忆功能负责跨对话的连续性,确保上下文在多次交互中保持连贯;分支功能则支持单次对话的多线探索,用户可随时基于某个节点展开平行讨论。这种模式改变了传统AI对话“起点-终点”的固定结构,对话流程从单线程演变为树状结构,用户既能保持主对话脉络,又能灵活拓展支线内容。

对比豆包等同类产品,ChatGPT的优势在于解决了“一次性对话”的局限性。豆包虽能快速处理临时问题,但缺乏历史记录关联能力,用户难以在后续对话中延续此前讨论。而ChatGPT通过记忆功能保留上下文,配合分支功能实现“接力式”对话,用户可随时回溯或切换分支,使复杂问题的探讨更具连贯性。

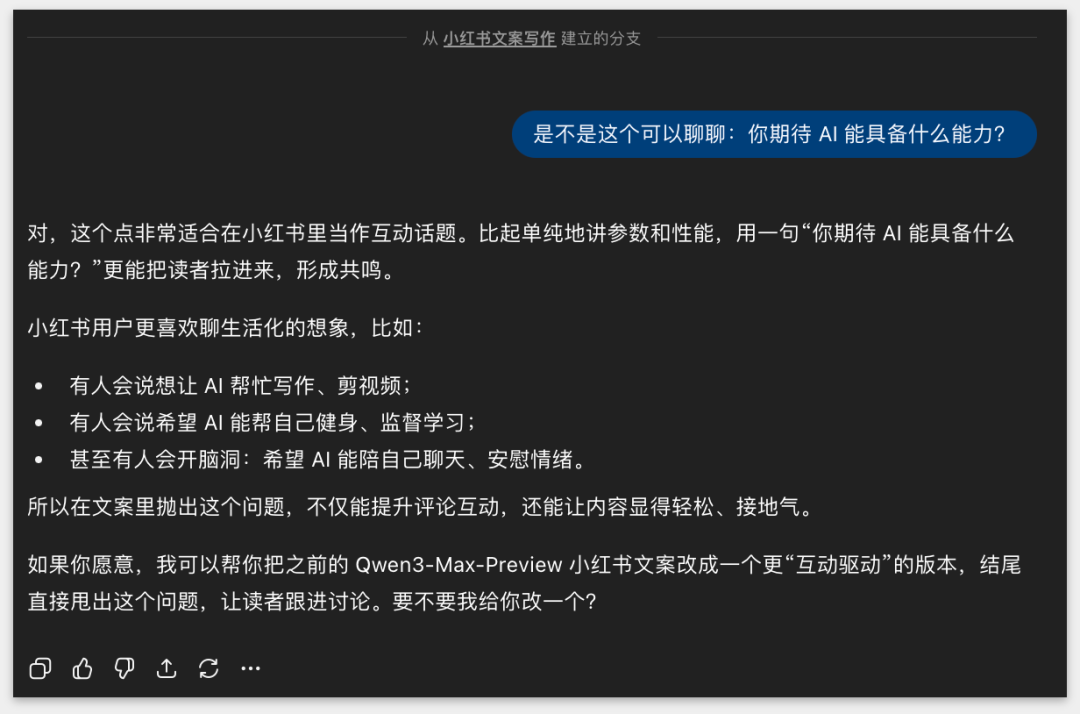

在实际应用中,分支对话显著提升了效率。例如用户撰写小红书文案时,若对AI生成的宏观描述不满意,可直接在回复节点创建分支,单独探讨具体能力需求,完成细节讨论后再返回主对话继续优化文案。这种切换过程自然流畅,AI能精准衔接上下文,避免信息断裂。

从知识管理角度看,ChatGPT的革新在于将对话过程转化为可追溯的知识体系。传统工具如Notion、飞书文档虽能结构化存储,但需用户主动整理归档,操作成本较高。而ChatGPT的对话记录自带语境,包含提问动机、推导过程和结论,这种“活”的知识比碎片化笔记更具价值。用户无需额外操作即可沉淀思考痕迹,后续通过分支回溯即可还原完整逻辑链。

这种设计对AI助理的定位产生深远影响。传统AI工具多聚焦于执行机械任务,如日程管理或文档优化,但在思维协作层面表现薄弱。而ChatGPT通过记忆与分支功能,展现出多线程协作能力:一个分支负责逻辑推理,另一个分支处理数据验证,再通过主分支整合输出,形成类似团队分工的协作模式。例如用户使用百度文库GenFlow时,可同时完成问题解答、海报设计、数据校验等多项任务,AI助理的角色从“执行者”升级为“共创伙伴”。

在上下文管理方面,ChatGPT的实践提供了新思路。当前行业普遍追求“无限上下文”窗口,但大窗口存在推理速度慢、成本高等问题。ChatGPT通过分支对话实现“书架式”信息管理,用户无需将所有资料塞入单一窗口,而是通过历史对话的分支调用或记忆延展获取信息。这种模式更符合人类思维习惯——通过关联记忆快速定位信息,而非依赖超长上下文。

随着功能演进,AI对话的边界持续扩展。未来用户可能无需在多个应用间切换,一个对话窗口即可完成文章撰写、表格生成、海报设计等复杂任务。例如调整合同文本时,用户可直接在对话中指令修改条款,AI自动调用PDF编辑工具生成最终版本。这种以对话为入口的“任务操作系统”,或将重新定义人机协作的形态。

当前国内AI产品在对话形态创新上相对滞后,多数仍聚焦于模型参数竞争或价格补贴。ChatGPT的实践表明,对话功能的深度优化可能比单纯提升技术指标更具价值。如何通过记忆、分支等设计重构人机交互逻辑,或将成为下一代AI产品的竞争焦点。