美国南加州大学约书亚·杨教授团队联合多国科研机构,成功研制出全球首款集成化人工神经元“1M1T1R”。该器件通过模仿生物神经元的工作机制,实现了皮焦耳级超低功耗运行,为构建类脑硬件学习系统开辟了新路径。相关成果发表于《自然·电子学》期刊,被学界视为通向通用人工智能(AGI)的关键技术突破。

研究团队从生物神经元的离子通道机制获得灵感,创新性地采用扩散型忆阻器作为核心元件。这种特殊材料在电压作用下,内部银离子会形成动态导电通道,模拟神经信号的积累与释放过程。通过将忆阻器、晶体管和电阻进行三维垂直堆叠,科研人员成功将传统需要数十个晶体管才能实现的神经元功能,浓缩至单个晶体管尺寸的器件中,集成度提升两个数量级。

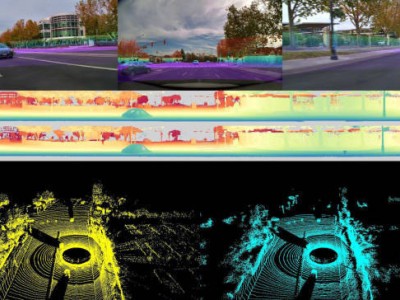

实验数据显示,该人工神经元在处理“喷发脉冲海德堡数字”语音识别任务时,准确率达到91.35%。这项测试要求系统同时解析语音信号的时间序列特征与空间频率信息,传统AI算法在此类时空数据融合任务中表现欠佳。研究负责人指出,1M1T1R神经元展现出的漏电积分、阈值放电等六大生物特性,使其能够像真实神经元般处理动态信息流。

能耗测试结果引发行业震动。当前版本神经元单次放电仅消耗1皮焦耳能量,相当于蚊子振翅能耗的千分之一。研究人员通过3纳米制程工艺优化预测,未来能耗可降至艾焦耳级,较人脑神经元节能数千倍。这意味着由数十亿个此类神经元组成的电子大脑,处理现有服务器级AI任务时,仅需手表电池即可持续运行。

在硬件架构层面,该技术突破了冯·诺依曼结构的瓶颈。传统计算机处理AI任务时,CPU需反复从内存调取数据,导致高能耗与延迟。而1M1T1R神经元网络采用事件驱动型异步通信,信号以脉冲形式在神经元间直接传递,这种并行处理模式与人脑工作机制高度相似。实验显示,由32个神经元组成的微型网络,在平衡球控制任务中展现出实时轨迹预测能力。

项目联合负责人透露,美国空军研究实验室与NASA自2018年起便参与核心技术攻关。在器件制备环节,科研团队运用原子层沉积技术,在纳米尺度精准控制忆阻器与晶体管的界面特性。电学测试环节则开发出专用脉冲发生系统,能够捕捉纳秒级信号变化。经过七年技术迭代,器件寿命从最初的数百次循环提升至百万次级稳定运行。

该成果对AI硬件发展具有双重意义。在应用层面,超低功耗特性使类脑芯片有望植入可穿戴设备或医疗监测装置。在学术层面,随机性放电特征为机器学习提供了新的优化路径——实验表明,适当引入神经元级噪声可使网络跳出局部最优解,在图像复原任务中将峰值信噪比提升12%。

目前研究团队正与半导体企业合作推进7纳米制程工艺开发。最新模拟显示,采用先进制程的芯片可将神经元密度提升至每平方毫米10万个,较现有GPU的运算单元密度提高三个数量级。这项技术或将在五年内实现商业化,为自动驾驶、实时语音翻译等领域带来革命性变化。

相关论文:https://www.nature.com/articles/s41928-025-01488-x

技术解读:https://www.sciencedaily.com/releases/2025/11/251105050723.htm