当闭源大模型阵营还在“参数至上”的赛道上狂飙时,开源领域突然杀出一匹黑马——Qwen3-Next 80B。这款总参数仅800亿的模型,通过极致稀疏的MoE架构,实现了单次激活参数仅30亿的突破,训练成本降至同级别模型的十分之一,却在32K以上长文本处理中展现出十倍于传统架构的吞吐能力,甚至原生支持256K超长上下文。这种“小体积、大能量”的表现,让开源社区看到了挑战闭源巨头的可能性。

Qwen3-Next的核心创新在于其混合架构设计。模型采用1:50的极稀疏MoE架构,在512个专家模块中,每个token仅激活10个专属专家与1个共享专家,实际参与计算的参数占比不足3.75%。这种“按需调用”的机制,配合Gated DeltaNet与标准Attention的混合注意力方案,既保证了长文本处理的效率,又维持了全局信息的召回能力。实验数据显示,在256K超长上下文场景下,该模型在RULER测试中取得93.5%的准确率,全区间平均准确率达91.8%,甚至超越了参数规模是其三倍的闭源模型。

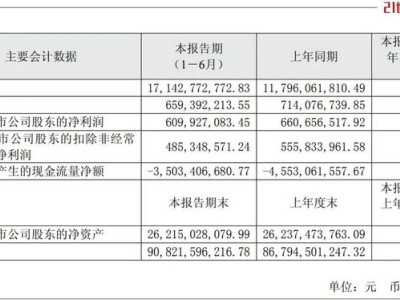

训练效率的革命性提升同样引人注目。通过使用Qwen3语料库15T tokens的子集,Qwen3-Next 80B的GPU资源消耗不足32B模型的9.3%。这种“省钱更省心”的特性,得益于模型在稳定化手段上的多重突破:zero-centered与weight-decayed LayerNorm的引入,MoE Router的归一化改进,以及专家初始化的公平性优化,共同确保了大规模训练的稳态收敛。官方测试显示,在4K场景下模型性能已有显著提升,而在32K以上长文本处理中,推理速度较传统架构提升近十倍。

后训练阶段的优化让模型实力全面爆发。Instruct版本在SuperGPQA、AIME25等基准测试中,与235B旗舰模型难分伯仲,部分任务甚至实现反超;Thinking版本则在复杂推理任务中展现出更强竞争力,在IME25、HMMT25等指标上全面领先Gemini-2.5-Flash-Thinking。特别是在LiveCodeBench v6编程基准测试中,80B模型以56.6分的成绩超越了235B模型的51.8分,验证了混合架构在代码生成等生产力场景中的优势。

社区实测反馈进一步印证了模型的实用性。有开发者测试发现,在处理千行级代码生成任务时,Qwen3-Next展现出强大的逻辑连贯性;但在网页信息整理等场景中,模型偶尔会出现“偷懒”现象,直接引用原文片段而非生成全新内容。尽管存在版式稳定性等细节问题,多数体验者仍认为,在100B参数规模以内,该模型已具备与闭源巨头正面竞争的实力。一位资深开发者评价:“当A100B+级别的新版本量产时,开源生态将迎来真正的转折点。”

值得关注的是,Qwen3-Next的技术突破并非终点。通过YaRN技术,模型实际支持的上下文长度已稳定扩展至百万级,这意味着跨月长对话、整本书理解等场景已具备落地条件。研发团队透露,基于当前架构的Qwen3.5正在筹备中,未来版本将进一步强化智能水平与生产力表现。从撕开235B防线到突破百万级上下文,Qwen系列正以独特的性价比优势,重塑开源与闭源阵营的竞争格局。